AI 服务器电源三大核心架构:UPS、AC/DC、DC/DC 深度解析

01.AI 服务器用电需求的本质变化:从“功率增长”到“供电体系重构”

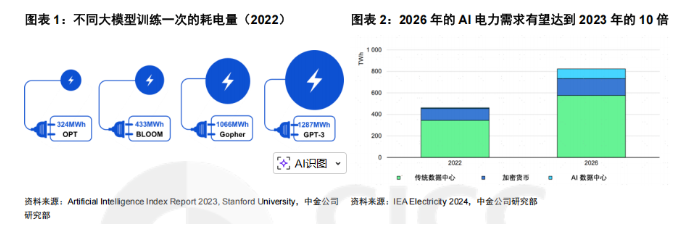

AI 带来用电需求的急剧上升。OPEN.AI CEO萨姆·奥特曼在 2024 年初的达沃斯论坛上表示“AI 技术消耗的电力超出人们预期”。根据 Artificial Intelligence Index Report 2023 其中 Deepmind Gopher、Hugging Face BLOOM、OpenAI GPT-3、Meta OPT 一次训练需要消耗的电力约为 1066MWh、433MWh、1287MWh、324MWh。根据 IEA 的数据,2023 年英伟达的芯片消耗电力 7.3TWh,而到 2026 年 AI 带来的电力消耗有望达到 2023 年的 10 倍。

AI 电力消耗主要集中于服务器和冷却系统。生成式人工智能需要部署大规模的数据中心进行训练和推理,而由于大模型大规模的参数量级因此也带来庞大的计算需求,进而消耗较高的能量。根据 IEA 的统计,数据中心的电力消耗 40%来源于数据计算,40%来源于冷却系统,剩余 20%则主要系相关的 IT 设备等消耗。

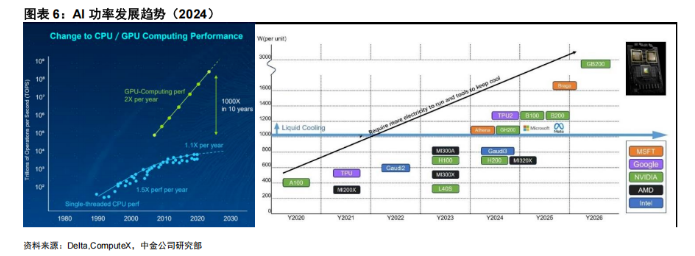

AI 服务器对电力系统的冲击,绝不仅仅是“GPU 功耗变大”这么简单。从工程角度看,真正的变化在于功率密度、瞬态电流、系统冗余和能效约束同时被推到新的量级。当单颗 AI 芯片的功耗从 300W 发展到 700W、1000W 甚至更高时,其对应的并不是线性放大的电源需求,而是对整个供电体系稳定性和控制能力的系统性挑战。尤其是在大模型训练场景下,GPU 的负载并非恒定,而是随算子类型、通信密集度和并行策略剧烈波动,这直接导致电流在极短时间内发生大幅变化,对供电系统的动态响应能力提出了前所未有的要求。

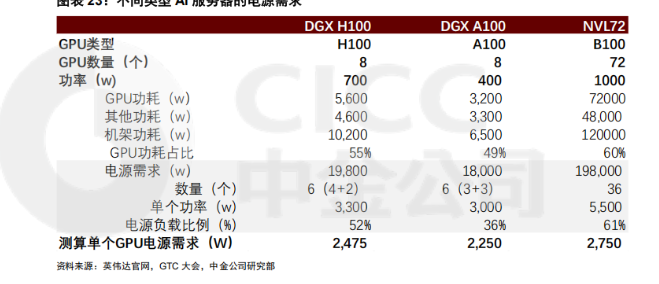

与此同时,AI 服务器的功耗结构也发生了明显变化。在高端 AI 平台中,GPU 虽然仍是最大单一耗电单元,但其功耗占比往往已下降至 50%–60% 左右,其余部分来自 CPU、HBM、高速互连芯片、板级损耗以及散热系统本身。这意味着,系统级功耗始终显著高于 GPU 标称功耗,电源设计必须覆盖更大的功率裕量与瞬态峰值,而不能仅围绕“GPU TDP”做静态匹配。也正是在这种背景下,电源系统第一次从“满足额定功率”的角色,转变为“保障算力持续释放”的关键基础设施。

更重要的是,AI 时代正在快速逼近“芯片侧能效提升的边界”。制程进步和架构优化仍然有效,但当单芯片工作电压下降至 0.7–0.9V、电流攀升至千安级别后,I²R 损耗开始成为决定系统效率的核心变量。在这一阶段,哪怕是极小的供电路径电阻变化,都会在高电流条件下被指数级放大。于是,能效优化的重心开始不可逆地从“算力芯片”转移到“供电架构本身”,电源不再只是电力的“搬运工”,而是能效天花板的决定因素之一。

02.AI 服务器电源架构演进:Power Shelf 与 DC/DC 正在成为系统核心

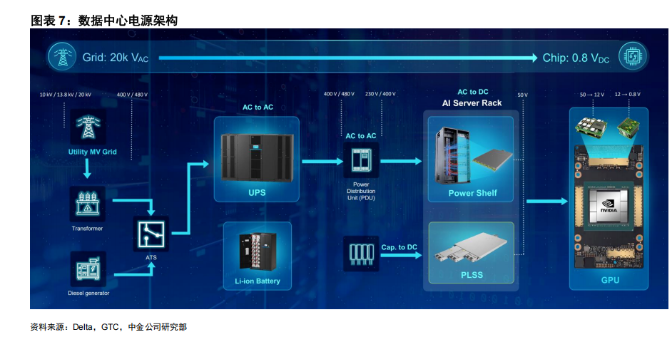

AI 服务器电源的基础架构如何?整体来看,AI 电源的架构从供电次序的角度来看主要分为三级:UPS—AC/DC—DC/DC。在数据中心的电力从电网传输到加速器芯片的过程中,电压要从 1-3 万伏特降低至 0.5~1 伏特,在这个过程中数据中心电源的架构主要分为保障电路 UPS、机架电源 AC/DC、芯片电源模组DC/DC 三个层级。

► UPS(不间断电源):UPS 是将蓄电池和主机连接,通过逆变电路等模块将直流电转化为市电的系统装置,在市电正常时对电压、频率进行在线控制进而为负载提供稳定电压、频率的优质交流电并给蓄电池充电;但当市电故障(断电、过/欠压)的时候,逆变电路则将蓄电池的直流电转化为电压、频率稳定的交流电给负载供电,以维持负载的正常工作防止数据丢失。

► AC/DC:由于 AI 服务器功率更高需要更多的电力,为了减少电力的损耗,电压输出从传统的 12V 提升至 50V,此后再经过层层降压以达到芯片的工作电压。AC/DC 环节的输入是 PDU 输入的交流电,经过降压、整流两个过程最终输出 50V 直流电。

► DC/DC:DC/DC 环节则进一步将电压调降至芯片可用电压,一般而言分为两步进行,第一步是 50V 降至 12V,第二步是 12V 降至 0.8V。

当下随着AI服务器的功耗飙升,服务器机柜用电需求飙升,在这种用电特征下,传统服务器“单 PSU + 12V 母线”的供电方式已经难以继续扩展,AI 服务器迅速转向以 Power Shelf 为核心的机架级供电架构。这种架构的本质,是将 AC/DC 转换从服务器内部上移至机柜层面,通过多模块并联的方式集中交付数十千瓦乃至上百千瓦的电力,再以更高电压向下游分配。从工程视角看,这种变化并非为了追求形式上的集中化,而是为了在功率急剧放大的情况下,依然能够控制效率曲线、热设计和冗余策略。

在当前主流 AI 机柜中,Power Shelf 通常以 30–33kW 为单元功率,多组并联构成 100kW 以上的供电能力,而实际运行负载往往被刻意控制在 50%–60% 区间。这一看似“过度配置”的设计,其实是基于三个现实考量:其一,电源在中等负载区间效率最高;其二,必须覆盖 AI 负载带来的瞬态功率峰值;其三,高端数据中心对 N+1 甚至 N+N 冗余有硬性要求。与此同时,输出母线电压从 12V 提升至 48V/50V,已经成为事实上的行业共识,其目的非常直接——在功率持续提升的情况下,尽可能降低母线电流,从而压制线损与发热。

但真正的技术难点,并不完全在 AC/DC,而是在DC/DC 及其所代表的“芯片级供电体系”。AI 芯片所需的电压极低、电流极大,传统在主板边缘集中降压、再通过长走线横向供电的方式,在千安级电流面前暴露出明显瓶颈。板级铜损、寄生电感和热集中问题,使得供电效率和稳定性难以继续提升。因此,行业正在系统性转向更贴近负载的供电方式,将 DC/DC 模块尽可能靠近芯片,甚至引入封装级、背面供电或纵向供电网络。这一演进并非单点技术升级,而是电源、封装、PCB 和散热协同设计的结果,其复杂度已经明显超出传统服务器电源的范畴。

03.AI 服务器电源进入“代际切换”阶段

正是由于供电架构的整体升级,AI 服务器电源市场正在经历一次明显的“代际切换”,而非简单的需求放量。一方面,功率密度成为衡量电源技术水平的核心指标,从传统服务器电源的 40–50 W/in³,跃迁至 AI 电源追求的 100 W/in³ 甚至更高。这背后不仅依赖于更先进的拓扑和宽禁带器件,也意味着散热方式、结构设计乃至制造工艺的系统性重构。在单模块功率不断抬升的背景下,电源自身的散热已经开始与服务器液冷体系深度耦合,电源厂商不再是“独立部件供应商”,而是算力系统联合设计的一部分。

另一方面,这种高复杂度、强定制化的产品形态,也直接重塑了竞争格局。当前高端 AI 服务器电源,尤其是 AC/DC Power Shelf 和高性能 DC/DC 模块,仍然高度集中在少数具备长期工程积累的厂商手中。这些厂商的优势并不完全体现在单项技术参数,而在于其对整机架构、负载特性和客户应用场景的深度理解,以及与 GPU 厂商、服务器 ODM 长期协同形成的工程闭环。相比之下,新进入者即便具备一定器件或成本优势,也往往需要跨越漫长的验证周期,才能真正进入核心供应链。

从更长周期看,AI 服务器电源的机会窗口并非不存在,但其逻辑已经发生变化。未来的竞争焦点,不再是“谁能做出一个高功率电源”,而是“谁能在算力持续升级的过程中,稳定交付高效率、高可靠性、并与液冷和封装趋势高度匹配的供电系统”。这意味着,AI 电源行业正在从传统意义上的制造业,逐步向系统工程与基础设施技术靠拢,其价值和门槛,也将随算力时代的深入而持续抬升。

04.全球AI服务器电源市场规模,竞争格局

AI 服务器电源需求仍远大于其服务器的 GPU 功率需求,其一在于 CPU 等其他功耗占比,其二在于电源的冗余设计。服务器电源往往采用冗余设计,如前文台达电的测试数据所示,负载比例在 50-60%的区间内电源具有最好的效率表现,我们测算 DGX H100、NVL72 等先进 AI 服务器的电源负载比例也大多在 50-60%。此外考虑到 CPU、输等其他的损耗,GPU功耗占机架整体功耗我们预计约为 50-60%。

► 以 DGX H100 为例:整体采用 8 个 H100 GPU,单个功率约为 700w,整体 GPU 功率约为 5.6kw,此外考虑到 CPU 及其他 DGX H100 的整体机架功率约为 10.2kw。其电源需求约为 6 个 3.3kw 的电源模组,电源功率约为 19.8kw,因此对应电源负载比例约为 52%

► 以 NVL72 为例:整机的功率约为 120kw,其电源需求约为 6 组 33kw 的 powershelf,对应的负载比例约为 61%。

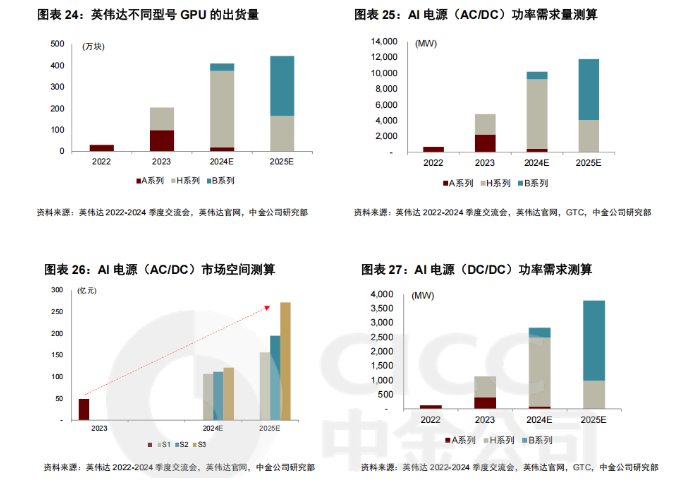

2024/25 年 AI 电源(AC/DC)的需求有望到 10.2GW 和 11.8GW,DC/DC 的需求有望达到 3GW/4GW。我们结合不同类型的 GPU 出货量以及对应的电源负载比例和 GPU 功率与机架功耗比例综合2024/25年AI服务器的AC/DC电源需求分别为 10.2GW/11.8GW,其中 B 系列的电源需求约为 0.96GW/7.7GW,A 和 H 系列的电源需求约为 9.2GW/4.1GW。此外考虑到 DC/DC 电源模块主要是布置于芯片基板,因此整体功与 GPU 工作功率接近,但结合此前台达在 ComputeX 大会上给出的基板损耗,我们假设损耗因数约为 5-15%,2024/25 年 DC/DC 的电源需求约为 3GW/4GW。

AI 服务器电源市场仍然以台系厂商为主,台达、光宝等占据主要市场份额。从 AI 电源的类型来看,其中 AC/DC 主要仍然以台系厂商为主,其中台达、光宝位列行业第一梯队,同时台系的群电、康舒也积极布局 AI 服务器电源,但大多以 AC/DC 为主。本土厂商来看,欧陆通、麦格米特、奥海科技等持续发力 AI 服务器电源。

DC/DC 的产品形态主要是嵌入基板的电源模组,主要以 MPS、Vicor、台达电等厂商为主。从收入规模来看,台达、光宝仍然占据领先地位,我们测算 2023 年台达 AI 服务器电源收入约为 18~19 亿元,光宝 AI 服务器电源收入约为 8~10 亿元

我们看好本土厂商的 AI 服务器电源的市场突破。相较于普通服务器而言,AI 服务器电源的产品要求高,因此认证规格较高且时间较长,客户往往需要考察供应商在质量控制、交付能力、成本控制能力等维度,因此要成为下游客户的正式供应商往往需要经过较长的认证周期。一方面,从国产厂商来看,大多都已建立起完善的供应体系和质量标准体系,且产品不断推陈出新、升级迭代,具备向上突破的基础;另一方面,随着需求端的持续扩张,终端客户也同样具有引入多元供应商来保障供应的需求,因此我们看好本土品牌在 AI 服务器电源中的突破升级。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。