Ming-Flash-Omni 2.0 核心亮点:语音音效音乐同轨生成,开源全模态新标杆

一、介绍

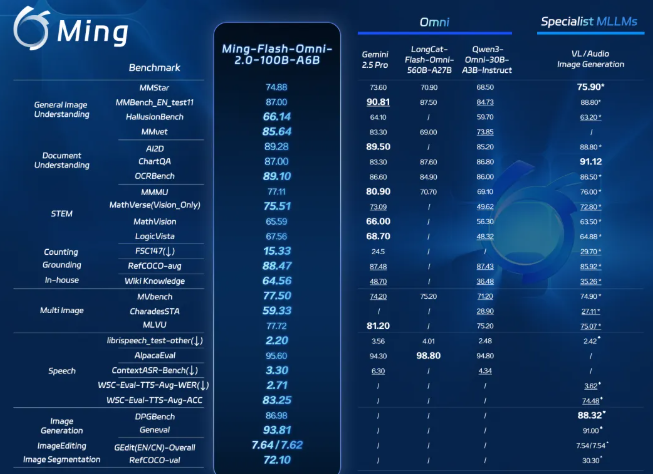

2026年2月11日,蚂蚁集团正式开源全模态大模型Ming-Flash-Omni 2.0。该模型是业界首个支持语音、环境音效与音乐同轨生成的全场景音频统一模型,支持自然语言精细调控音色、语速、情绪等参数,推理帧率达3.1Hz,可实现分钟级长音频实时高保真生成。在多项公开基准测试中,该模型在视觉语言理解、语音可控生成、图像生成与编辑等关键能力表现突出,部分指标超越 Gemini 2.5 Pro,成为开源全模态大模型性能新标杆。

与蚂蚁 2025 年 5 月推出的 Ming-flash-omni Preview 相比,Ming-flash-omni 2.0 实现了跨代升级,侧重于优化以下关键领域的功能:

1、专家级多模态认知:它能精准识别动植物以及文化典故,并对文物进行专家级分析。通过将高分辨率视觉捕捉与庞大的知识图谱相结合,该模型实现了 " 视觉到知识 " 的合成,知识理解能力更强。

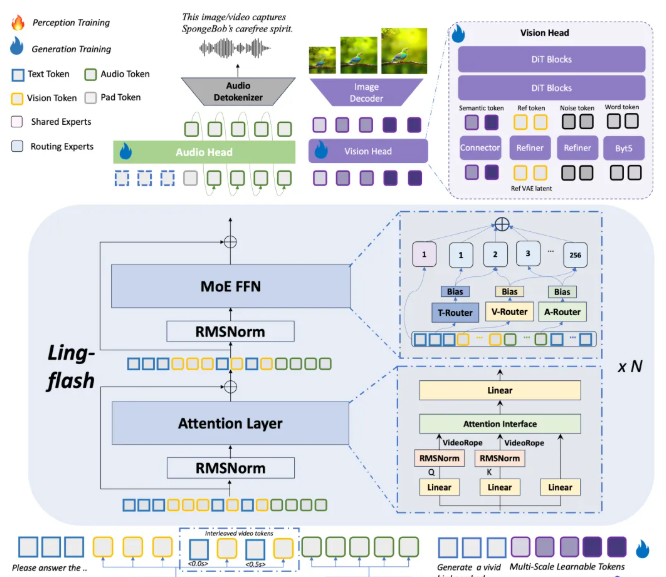

2、沉浸式可控统一声学合成:它引入统一的端到端声学生成流程,将语音、音频和音乐集成于单一通道中。该模型利用连续自回归算法结合扩散变换器 ( DiT ) 头部,实现了零样本语音克隆和精细的属性控制,例如情感、音色和环境氛围,大幅提高听觉体验。

3、高动态可控图像生成与处理:它采用原生多任务架构,整合了分割、生成和编辑功能,实现了精细的时空语义解耦。它在高动态内容创作方面表现卓越,包括大气重建、无缝场景合成和上下文感知物体移除,且能在复杂的图像处理任务中达到顶尖精度。

目前,Ming-flash-omni 2.0 的模型权重、推理代码已在 Hugging Face 等开源社区发布,用户也可通过蚂蚁百灵官方平台 Ling Studio 在线体验与调用。

Hugging Face:https://hf-mirror.com/inclusionAI/Ming-flash-omni-2.0

GitHub:https://github.com/inclusionAI/Ming

魔搭社区:https://www.modelscope.cn/models/inclusionAI/Ming-flash-omni-2.0

体验入口:https://ling.tbox.cn/chat

二、核心亮点

业内普遍认为,多模态大模型最终会走向更统一的架构。但现实是 " 全模态 " 模型往往很难同时做到通用与专精,在特定单项能力上往往不及专用模型。

Ming-omni 系列正是在这一背景下持续演进,早期版本构建统一多模态能力底座,中期版本验证规模增长带来的能力提升,而最新 2.0 版本通过更大规模数据与系统性训练优化,将全模态理解与生成能力推至开源领先水平,并在部分领域超越顶级专用模型。

此次蚂蚁集团将Ming-flash-omni 2.0在这些方面实现提升,达到了整体跨代的效果。Ming-flash-omni 2.0 基于 Ling-2.0 架构(MoE,100B-A6B)训练,主要围绕 "看得更准、听得更细、生成更稳" 三大进行了优化。

视觉方面,该模型融合亿级细粒度数据与难例训练策略,显著提升对近缘动植物、工艺细节和稀有文物等复杂对象的识别能力。

音频方面,其实现了语音、音效、音乐同轨生成,支持自然语言精细控制音色、语速、情绪等参数,并具备零样本音色克隆与定制能力。

图像方面,其增强了复杂编辑的稳定性,支持光影调整、场景替换、人物姿态优化及一键修图等功能,在动态场景中仍保持画面连贯与细节真实。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。