特征工程 2.0 全解析:大模型时代 AI 数据精炼核心指南

随着新一轮 AI 革命的到来,无论企业规模大小,都正经历着如何将 AI 融入业务的焦虑。“含 AI 量”已成为衡量未来竞争力的重要指标。纵观整个AI生态系统——上至构建算力地基的基础设施供应商,中至训练基础大模型的行业巨头,下至利用AI提效业务的应用开发者——其所有活动都围绕着同一个核心要素展开:高质量的数据。

然而,即便企业已经拥有完善的数据湖和数据仓库,当真正迈向 AI 应用时仍会困惑:“我们既有海量数据,也已有强大模型,为什么工程师仍把大量时间花在数据处理上?”原因在于,特征工程并未消失,而是进化了。在文本场景下,随着大模型能够自动从原始数据中学习语义特征,而不再依赖人工构造的数值特征,传统 Feature Engineering 1.0 时代那些手工构造数值特征、统计特征的做法确实少了。但特征工程的本质——将原始信息加工成模型“真正能用”的结构与语义——从未减少,只是从“特征构造”迁移为了“语义精炼”。

在今天的 AI 项目中,数据准备依然是最耗时的工作。大量时间被投入到语料清洗、指令数据整理、文档切分、知识块设计、元数据补充、语义对齐和检索特征构建等任务上;模型决定可能性,数据决定可实现的程度。

这一规律在 AI 的发展历史中屡次被证明。2012 年深度学习革命之所以真正爆发,并非因为CNN本身突然突破,而是因为李飞飞团队构建的 ImageNet 数据集首次为神经网络提供了足够规模且高质量的训练信号,点燃了深度学习时代。

因此,如果说数据是新时代的石油,那么特征工程仍然是将原油提炼为高标号航空燃油的核心精炼过程。不同的是,在 Feature Engineering 2.0 时代,这种燃油不再是人工构造的数值特征,而是结构化、语义化、上下文化的知识表达。尽管形式发生改变,特征工程的价值不仅没有削弱,反而成为大模型时代最重要、又容易被忽略的工作之一。

从 Feature Engineering 1.0 到 2.0

从 1.0 到 2.0特征工程演进的三个阶段如下,在 1.0 时代,我们为算法造特征;在 2.0 时代,我们为模型造语境。

| 阶段 | 特征形态 | 关注点 | 典型任务 | 代表范式 |

|---|---|---|---|---|

| Feature Engineering 1.0 | 数值向量(表格/统计特征) | 字段特征(Feature as Columns) | 特征提取、转换、选择 | 传统机器学习(ML) |

| Feature Engineering 1.5 | 表征向量(embedding) | 数据分布(Feature as Dataset) | 自动特征学习、语义压缩、数据增强 | 深度学习(DL) |

| Feature Engineering 2.0 | 语义结构化输入(文本指令、知识块、工具描述) | 知识与语义结构(Feature as Knowledge / Behavior) | 语料构建、RAG预处理、上下文设计、Agent工具描述 | 大模型训练与Agentic AI |

注意:即便进入2.0时代,大模型训练阶段仍可能结合1.0或1.5时代的特征,如数值统计特征或embedding,用于多模态融合或辅助任务。核心迁移在于模型最关键的学习信号已从数值向量转向语义化、结构化的知识与上下文。

Feature Engineering 1.0

特征工程(Feature Engineering)是通过领域知识、统计分析、或自动化方法,将原始数据转换为对学习算法有更高预测能力的输入变量(features)的系统化过程。

其核心活动包括:

- 特征提取:从原始数据中创造出新的、更有信息量的特征。

- 特征转换:对现有特征进行变换,使其更适合模型学习。

- 特征选择:从众多特征中,识别并挑选出与预测目标最相关、冗余度最低的特征子集,以提升模型效率和泛化能力。

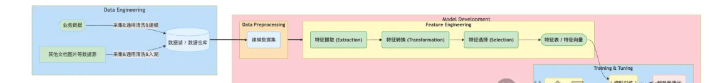

需要强调的是,特征工程所处理的“原始数据”是一个相对概念。如下图所示,对于数据湖而言,它的原始数据是业务数据;而对于ML模型训练而言,来自数据仓库的宽表、主题数据集等尚未经过针对性特征化处理的输入数据,同样被视为需要进一步加工的“原始数据”。为了更清晰地理解其做的事情,可以将一个典型的模型训练流程与烹饪过程进行类比:

- 数据预处理 (Data Preprocessing) ≈ 挑选食材:确保原材料的基本可用性。

- 特征工程 (Feature Engineering) ≈ 精心清洗与切配:最大化食材的价值潜力。

- 模型选择 (Model Selection) ≈ 选择合适的菜谱:决定最终的烹饪方法。

- 超参数调优 (Hyperparameter Tuning) ≈ 反复调试火候:对烹饪过程进行精细控制。

Feature Engineering 1.5

随着深度学习的普及,特征工程进入自动化阶段:特征形态:数值向量被表征向量(embedding)取代。关注点:从单字段扩展到数据分布层面,模型能够自动学习有用表征。典型任务:自动特征学习、语义压缩、数据增强。1.5时代的核心价值在于减少人工设计特征的成本,并为复杂模型提供更丰富的语义信息。

Feature Engineering 2.0

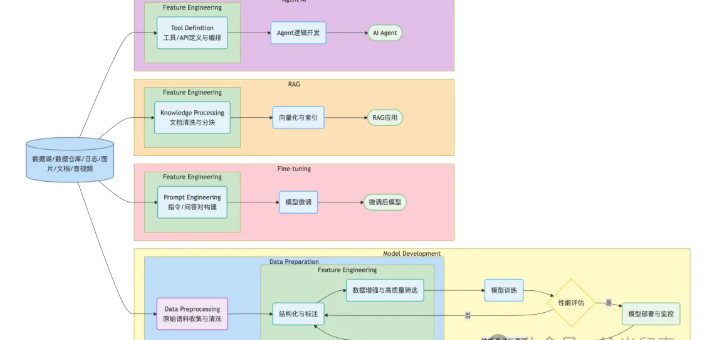

进入大模型与Agentic AI时代,特征工程的核心目标发生根本变化:不再仅仅优化算法,而是构建模型能理解和利用的语境。业界的称呼也发生了变化,开始流行称为LLM Data Engineering(LLM 数据工程)和RAG/Knowledge Engineering(语义与知识特征工程)。

- 大模型训练需要的特征是结构化、语义化的文本或多模态输入,用于让模型学习上下文关系和语义规律。

- 模型微调:需要结构化的指令-回答对,作为模型高效学习的语料特征。

- RAG 应用:需要经过清洗、Chunking并向量化的知识块,作为可检索、可利用的核心特征。

- Agent AI:需要清晰、结构化的工具或 API 描述,使模型能够理解、调用和组合操作。

- 多模态或混合任务:传统数值特征或 embedding 仍可能作为辅助信号存在,用于补充语义信息或上下文。

特征工程是一个系统化过程,通过领域知识、数据分析或自动化方法,将原始信息重构为结构化、模型友好的形式,旨在最大化 AI 模型在目标任务上的实际性能。

在 FE 2.0 的背景下,可以将其理解为三个核心思想:

- 信息结构化:将非结构化原始信息转化为定义清晰、一致的结构形式。

- 语义表征:通过特征设计揭示信息内在含义与关系,使模型能够理解和利用。

- 价值对齐:确保最终特征直接、高效地服务于模型学习目标和具体任务需求。

2.0时代FE的位置

在任何一个AI项目中,特征工程都扮演着一个“承上启下”的枢纽角色。在数据流上,它是连接上游数据资产与下游智能应用的关键桥梁;而在工作流中,它更是所有AI应用/foundation model训练开发中第一个也是最为核心繁重的迭代环节。下面的工作流直观地展示了数据在经过初步处理后,如何流向不同的AI开发场景。

如图所示,特征工程在 FE 2.0 中不是一次性的,而是整个 AI 生命周期的循环枢纽。

- 当模型性能未达预期时,问题可能源自训练语料或特征设计,包括标注质量、结构化方法、增强策略或指令构建。分析模型输出和错误,可以为优化特征、调整数据结构或重建语境提供关键线索。

- 模型上线后,外部环境或知识变化可能导致性能下降。一旦监控到效果衰退,FE 优化迭代就会触发,包括更新语料、修正标注、增强数据、重建知识块或调整工具/指令描述,以保持模型持续有效。

在大模型训练的初始阶段,数据首先经过 Data Preparation 总括性环节:

- 原始语料收集与初步清洗:确保输入数据可用,但不涉及高阶特征加工。

- Feature Engineering:大模型训练最核心的工作之一,包括两类活动:

FE 的脑力消耗和对最终结果的影响通常远大于数据预处理。所有大模型训练、微调、RAG 或 Agent AI 的迭代几乎都围绕 FE 展开:“特征工程 → 模型训练 / Agentic AI 开发 → 性能评估 → 特征优化”,形成循环闭环。FE 占据了 AI 项目开发的大部分时间。

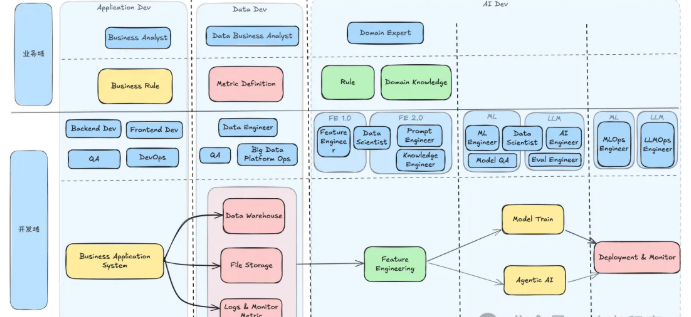

核心角色演变

一项核心工作由谁来负责,不仅决定了工作的质量,更深远地影响着一家公司的人才构成与组织架构。特征工程职责的归属方式,往往能反映出企业AI战略的成熟度。

请注意对由于工作经验差异而衍生的角色称呼并未一一列举,比如Software Architect、Data Architect等,只描述完成工作最基本角色名称,而且不同公司对角色称呼也可能存在差异。

在当前许多公司中,这些Prompt Engineer, Knowledge Engineer“新角色”往往还不是独立的岗位,而是由AI工程师或资深MLE来承担的新职责。

- 在 FE1.0 时代 feature engineering 的工作有没有专门的 feature engineer 来负责,它取决于公司的规模和AI成熟度,像在AI技术应用极度成熟和规模化的巨头公司,如Meta、Google、国内大厂等,确实存在或曾经存在过专门的特征工程师。在这些公司,机器学习平台(尤其是Feature Store)是核心基础设施。在绝大多数企业中,特征工程师并非一个独立的岗位,它的职责通常被融入到其他角色(尤其是数据科学家)的日常工作中。

- 在 FE 2.0 时代,Prompt Engineer 与 Knowledge Engineer 的出现是因为随着LLM和知识驱动系统的发展,特征扩展到语义、文本、知识图谱等复杂信息。Prompt Engineer 负责设计和优化 prompt,使 LLM 能够从特征和业务知识中输出高质量结果,相当于“用自然语言写特征”;Knowledge Engineer 则将领域知识、规则和结构化信息整合成可用特征或知识表示,以供模型使用,从而实现半自动化、语义化的特征提取流程。

- 在 LLM 时代,传统的 Machine Learning Engineer 逐渐演变为 AI Engineer,因为现代模型工程不仅需要掌握模型训练、部署和维护,还需具备与 LLM、Agentic AI 系统交互的能力,能够整合 Prompt 与 Knowledge 特征,并进行模型评估和自动化迭代。原 MLE 角色侧重于将DS的算法和模型成果进行工程化落地,而 AI Engineer 在继承这一职责的基础上,进一步扩展了对大模型微调、RAG 系统和系统能力的掌握,成为技能要求更广泛的复合型角色。

- 在应用开发和大数据开发时代,传统 QA 角色主要关注系统正确性和功能测试,而在 AI/LLM 时代,由于模型输出不可预测,已不再是测试正确与否,而是好坏之分,Eval Engineer 应运而生。Eval Engineer 负责评估模型输出质量、进行指标打分、自动化对比和人类反馈收集,是传统 QA 的智能化升级,更加侧重模型输出效果和业务指标的衡量,确保 AI 系统在复杂环境下的可靠性与价值。

核心技术

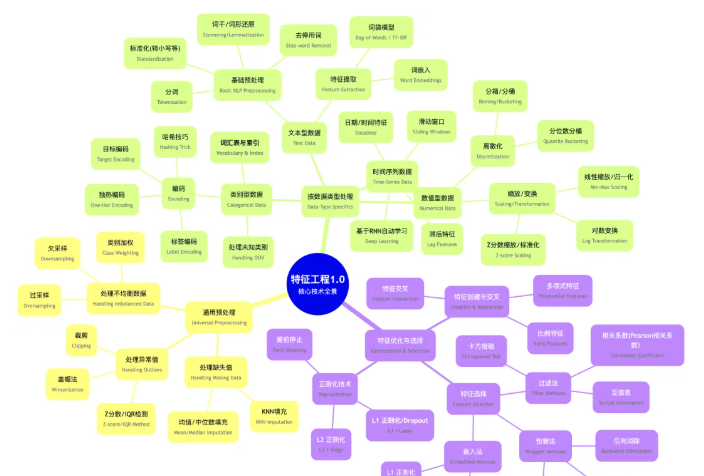

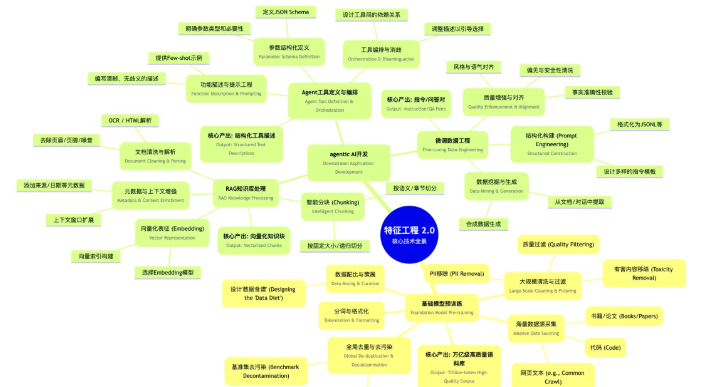

想必从事 AI 相关开发工作的人,如果不是需要从零编写模型算法,对feature engineering 工作应该是最头疼的,此部分工作所需方法论繁杂且不少需要数学理论为基础,所以本文尽量把目前常用到的方法做了脑图,一是直观展示二是方便查阅,甚至可以快速以此为索引开发一个 RAG 系统,在进行 feature engineering 工作时进行准确建议。

Feature Engineering 1.0

此图的知识体系划分为三个逻辑层层递进的阶段:

- 第一阶段通用预处理主要聚焦无论什么数据类型都可能遇到的“通用麻烦”,解决数据质量问题,为后续所有工作打下基础。

- 第二阶段按数据类型处理,将不同类型的原始数据,转换为模型可以理解的数值表示。针对数值型、类别型、文本型等主要数据类型,列出了所有专属的处理和转换技术。

- 第三阶段特征优化与选择,在已经获得大量可用特征后,进行“优中选优”,创造更高阶的特征,并剔除冗余信息,以提升模型最终的性能和效率。

Feature Engineering 2.0

- 基础模型预训练的数据特征工程是将整个互联网的“矿石”提炼成可供模型学习的“高纯度硅”。核心产出是一个经过极致清洗、去重和精心搭配的万亿级高质量语料库。

- agentic AI应用开发的数据特征工程是利用已经炼好的“高纯度钢”(基础模型),为特定场景打造锋利的“宝剑”。它更侧重于将特定领域的知识和任务,转化为基础模型能够理解和学习的格式。

FE1.0 时代主要采用 Pandas/NumPy/Scikit-learn 完成单机特征探索,利用 Spark/Dask 或 AWS Glue / Google Cloud Dataflow 等分布式系统进行大规模结构化特征计算;在 FE1.0 后期至 FE2.0 早期,Feast/Tecton 以及云上 Feature Store(SageMaker/Vertex AI)开始普及,用于统一管理、存储和服务线上/线下特征。

FE2.0 时代特征工程演变为 LLM 数据与知识构建:Label Studio/Scale AI 用于微调与偏好学习数据标注;Hugging Face 配合向量数据库(FAISS/Chroma/Milvus/Pinecone)构建 RAG 语义特征;LangChain/LlamaIndex/Dify/CrewAI 提供 Agent 的工具定义与执行框架。大模型训练数据预处理依赖各大厂自有云基础设施,常见底层工具包括 Spark/Ray,存储通常采用 S3/GCS 等对象存储。

工具生态是动态融合的,也在随着开发者的使用需求进化。例如,像Databricks这样典型的FE 1.0平台,现在正极其迅速地将FE 2.0的能力(如向量检索、LLM微调)深度集成进来。这表明两大时代的工具链正在加速融合。

未来展望

特征工程从未停止演化。站在 Feature Engineering 2.0 的门口,能看到通往 3.0 的方向——一个由 AI 自主驱动、最终沉淀为平台化能力的未来。

- LLM 正从“特征使用者”走向“特征协作者”:在 FE1.0 中,AI 将自动生成特征提取代码;在 FE2.0 中,它能自动构建微调指令、诊断 RAG 知识质量。随着多模态模型普及,跨文本/图像/音频的统一特征表征将成为下一代的关键挑战。

- 特征表达从“向量”迈向“图”:传统向量 RAG 捕捉相似度却缺乏结构理解,而 GraphRAG 将语义向量与知识图谱结合,实现多跳推理,可视为 1.0 时代“特征交叉”在 2.0 时代的重生,使模型从“检索信息”走向“理解知识”。

- 特征工程的终态将自动化、甚至“隐形”:FE2.0 的本质是 Context Engineering,而 FE3.0 的愿景则是让上下文能自我生成、自我调整。研究正在探索能“自动设计上下文”的 Agent,使工程师的角色从“做特征”→“做上下文”→“做能自己做上下文的系统”。

最终,这些趋势将可能沉淀为统一的“上下文平台”。高质量自然数据的红利正在减弱,但智能的成长不会因此停步。未来的竞争力,将不仅在于谁囤积了更多数据,更在于谁拥有一种能力——让有限的数据不断增殖、演化,并以最低成本转化为可持续驱动 AI 的能源。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。