AI有哪些分类?AI大模型基础及原理

一、AI大模型时代已来,你准备好了吗?

什么是AI?

AI的核心目标在于模拟并延伸人类的智能,使机器能胜任那些通常需要人类高级认知能力才能完成的任务。这包括从基础的语言理解、图像识别,到更复杂的决策分析、自主学习等一系列智能行为。

人工智能已经走过了几个关键发展阶段:

·早期阶段:以规则为基础的专家系统,依赖预设的逻辑和规则。比如1970年代,无人驾驶技术的研究;

·机器学习时代:通过数据训练模型,使机器能够从数据中学习规律。

·深度学习时代:利用神经网络模拟人脑的复杂结构,处理更复杂的任务。

·大模型时代:以大规模数据和算力为基础,构建通用性强、性能卓越的AI模型

当前,我们正处在大模型时代,了解其原理并掌握API使用已成为技术人员的基本技能。

二、AI的分类:了解你的工具

1. 分析式AI(判别式AI)

核心任务:对已有数据进行分类、预测或决策

优势:高精度、高效性

局限:只能处理已有数据模式,无法创造新内容

2. 生成式AI

核心任务:创造新内容,如文本、图像、音频等

优势:创造性、灵活性

挑战:数据隐私、版权保护

在实际应用中,我们需要根据具体场景选择合适的AI类型。如果你需要分析用户评论情感,分析式AI更合适;如果你需要生成广告文案,那么生成式AI是你的首选。

三、大语言模型(LLM)深度解析

1、什么是LLM?

大型语言模型是基于海量文本数据训练的深度学习模型,属于生成式AI。它能理解和生成类人类的自然语言,常见模型有GPT系列、DeepSeek、Qwen等。

核心能力:

• 文本理解、摘要、翻译、问答

• 内容创作

• 上下文关联对话

• 少量示例学习下游任务

场景示例:

•智能客服:电商网站导入基于LLM的聊天机器人,能即时理解客户复杂的售后问题,提供个性化的解决方案,大幅提升服务效率与客户满意度。

•内容创作:营销团队使用LLM,输入产品关键字和目标受众,快速生成多版本的广告文案、社交媒体帖文与博客文章,有效降低人力成本。

2、生图/生视频模型(Text-to-Image/Video)

• 专门将文字描述转换为全新的图像或视频。它们学习了图像、视频与其对应文字标签之间的关联,代表模型有DALL-E、Midjourney及Sora。

• 能够根据用户输入的文字提示(Prompt),创造出符合描述且风格多样的视觉内容。模型能融合不同概念、属性和风格,生成前所未有的原创作品。

场景示例:

• 产品设计:设计师输入“一款具有未来感的流线型运动跑鞋,采用回收海洋塑料材质”,模型可快速生成多款概念图,加速产品可视化与迭代过程。

• 影视预览:导演利用文字生成视频模型,将剧本中的关键场景转换为动态预览片段,以便在实际拍摄前,评估镜头、光影和场景布局的可行性。

3. 视觉识别模型(Computer Vision Model)

• 视觉识别模型让计算机能“看懂”并解析图像与视频内容,属于计算机视觉领域。主要任务包括图像分类、物体检测、图像分割等,模型如YOLO、ResNet。

• 能准确辨识影像中的物体、人脸、文字或特定场景。其核心在于从像素中提取特征,并与已知模式进行比对,以完成识别、定位或追踪等任务。

场景示例:

• 智能制造:在生产线上部署视觉识别系统,能即时检测产品外观的微小瑕疵,如刮痕或缺件,自动剔除不合格品,确保出厂品质,准确率远超人眼。

• 医疗影像分析:医院导入AI辅助判读系统,分析X光或CT扫描影像。模型能快速标记出疑似肿瘤或病变的区域,协助放射科医生提高诊断效率与准确性。

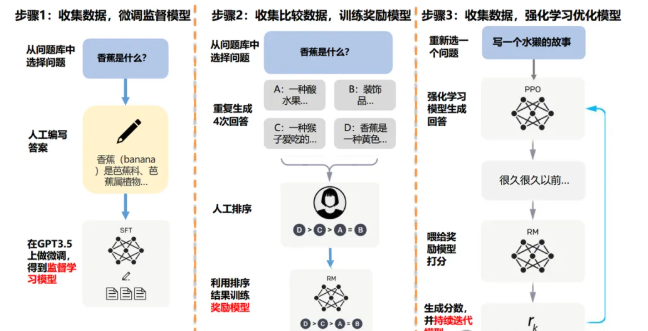

LLM的训练过程(以ChatGPT为例)

大语言模型是一种通用自然语言生成模型,使用大量预料数据训练,以实现生成文本、回答问题、对话生成等

训练步骤:

这里有个关键洞察:使用排序任务代替打分任务,因为让标注员给统一标准的排序比给出绝对分数更容易,这大大提高了数据标注的一致性。

强化学习阶段,我们让AI自我探索发掘出一系列新的答案,这些答案有好有坏,有比之前标注结果更好的,也有距离标准答案更远的,通过调整RANK List记录排名的方式,让AI明白哪个答案更准确,那种结果推断方向更正确。

随着大模型AI的不断发展,我们可以看到,大模型的参数量已经从GPT1时代的1.17亿,迭代到了GPT5时代的52万亿(2025年8月),有人揣测最终可能会突破100万亿参数的规模。当前的AI的创作灵感,就是来源于我们人类的大脑,我们模拟大脑工作方式,组装出了叫做“神经网络”的模型,进而发展出当前众多的AI模型,而我们人类大脑的神经元数量是多少?是250万亿,GPT5的突破100万亿,已经和人类神经元数量比较接近,基本处于同一水平。而且,我们为了训练大模型,已经至少向其投喂了至少45TB的数据,1TB数据量大约相当于1000万本书,而我们人类从0-20岁,最多看过学过1000本书的知识量,所以在这个层面来讲,我们人类个体和AI几乎没有可比性……这就是当前大模型所拥有的恐怖能力。

四、核心技术概念详解

1. Token:大模型的语言单位

Token是LLM处理文本的最小单位。模型无法直接理解文字,需要将文本切分成Token,再转换为数字向量进行运算。不同的模型使用不同的“分词器”(Tokenizer)来定义Token。

示例:

·英文"Hello World" → ["Hello", "World"]

GPT-4o 会切分为[“Hello“, ”World“] => 对应的 token id = [13225, 5922]

·中文"人工智能你好啊" → ["人工智能", "你好", "啊"]

DeepSeek-R1会切分为[“人工智能”, “你好”,“啊”] => 对应的token id = [33574, 30594, 3266]

小贴士:不同模型使用不同的分词器,这直接影响模型效率和对语言细节的理解能力。推荐使用在线工具 tiktokenizer 查看不同模型如何切分你的文本。

2. 特殊Token:模型的"标点符号"

为了让模型更好地理解文本的结构和指令,开发者会预设一些具有特殊功能的Token。这些Token不代表具体词义,而是作为一种“标点”或“命令”存在。

• 分隔符(Separator Token): 用于区分不同的文本段落或角色。比如,在对话中区分用户和AI的发言,可能会用<|user|>和<|assistant|>这样的Token。

• 结束符(End-of-Sentence/End-of-Text Token): 告知模型文本已经结束,可以停止生成了。常见的如[EOS] 或<|endoftext|>。这对于确保模型生成完整且不冗长的回答至关重要。

• 起始符(Start Token): 标记序列的开始,例如[CLS] (Classification) 或[BOS] (Beginning of Sentence),帮助模型准备开始处理文本。

3. Temperature与Top P:控制文本多样性的双刃剑

Temperatur和Top P是控制LLM 生成文本的多样性,但原理不同。

Temperature(温度):

·原理:调整下一个Token概率分布的平滑度

·低温度(0.2):结果稳定、保守,适合事实性问答

·高温度(1.0+):结果创造性高,可能不连贯,适合创意写作

Top P(核采样):

·原理:它设定一个概率阈值(P),然后从高到低累加所有Token的概率,直到总和超过P为止。模型只会在这个累加出来的“核心”词汇表中选择下一个Token。

·低Top P(0.1):候选词少,结果确定性强

·高Top P(0.9):候选词多,结果多样性高

举例:假设模型要完成句子:“今天天气真...”

模型预测的下一个词可能是:好(60%)、不错(30%)、糟(9%)、可乐(0.01%)。

高Temperature:会提升所有词的概率,使得“可乐”这个不相关的词也有机会被选中。

Top P (设为0.9):会选择概率总和达到90%的词。这里好(60%) +不错(30%) = 90%,所以模型只会从“好”和“不错”中选择,直接排除了“可乐”这种离谱的选项。

相比Temperature,Top P能更动态地调整候选词的数量,避免选到概率极低的离谱词汇=> 产生更高质量的文本。

实战建议:对于需要准确性的任务,使用低Temperature和低Top P;对于创意任务,可适当调高这两个参数。

五、AI聊天产品的"超能力"

1. 联网搜索:突破数据时效限制

弥补LLM训练数据截止日期的限制=>获取外部信息

当用户提问涉及最新资讯时,系统会识别出这一需求,自动调用搜索Tool,并将问题转化为多个简洁的搜索关键词。接着,程序调用搜索引擎API(如Google搜索)获取信息。

最后,这些实时信息会作为上下文提供给模型,由模型进行总结和提炼,生成精准且与时俱进的回答。

应用场景:查询最新股价、新闻事件、技术动态等。

例如,当你询问“黄金的涨跌和哪些因素有关?” LLM会调用一个搜索工具,输入你刚才的问题,然后获取相关的信息 => 整理到回答中。

2. 读取文件:基于RAG的技术

工作流程:

基于“检索增强生成”(Retrieval-Augmented Generation, RAG)的技术。

当你上传一个文件(如PDF、Word文档)时,系统首先会将其内容分割成小块(Chunks)。

然后,通过Embedding技术将这些文本块转化为数学向量,并存储在专门的“向量数据库”中。

当你针对文件内容提问时,系统会将你的问题也转化为向量,并在数据库中快速找到最相关的文本块,最后将这些文本块连同你的问题一起交给模型,生成答案。

应用场景:分析公司财报、技术文档、法律合同等。

比如,上传一份公司财报后,提问“第二季度的利润是多少?” RAG系统能精确定位到财报中相关的片段,让LLM直接使用。

3. 记忆功能:从"金鱼"到"伙伴"

LLM本身是无状态的,每次对话都是一次全新的互动,不记得之前的交流。

为了实现“记忆”,系统会在每次对话时,将最近的几轮问答作为背景信息一起发送给模型

=> 称为“短期记忆”或“上下文窗口”。

对于需要长期记住的关键信息,例如你的名字或偏好,系统会通过特定算法提取这些信息,

=> 将其存储在用户专属的数据库中。

=> 在后续的对话中,系统会先从数据库中读取,为模型提供更个性化的背景知识。

应用场景:记住用户偏好、对话历史、个人设置等。

比如,你告诉AI“我喜欢简洁的回答风格”,系统会记录这一偏好。

下次你提问时,它就会倾向于给出更简练的答复。

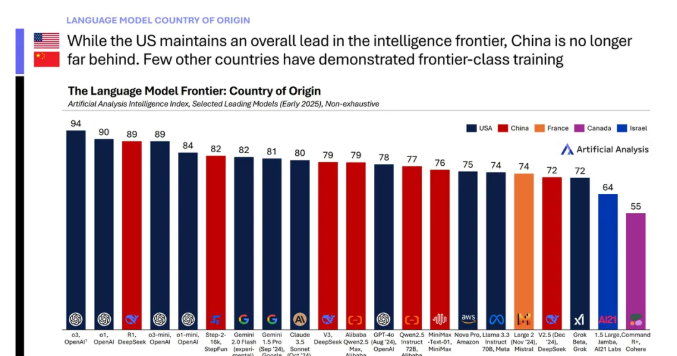

六、全球AI发展现状

如上图所示,无需多言,目前全球主流模型,都集中在中美两个国家,这也是当今全球人工智能竞争的两大主力区域。

上图展示了目前各主流推理大模型的综合排名(本排名截止2025年6月,相对较旧)

全球AI模型发展现状(中美对比):

• 美国:OpenAI、Anthropic、Google、Meta等公司主导前沿模型,如GPT-4o、Claude 4 Sonnet、Gemini 2.5 Flash。

• 中国:DeepSeek(如R1、V3)、阿里巴巴(如Qwen3)、Moonshot等公司快速追赶,部分模型(如Kimi K2, DeepSeek R1)已接近美国前沿水平。

•关键趋势:中国模型在2024年显著缩小与美国的差距,尤其在推理模型和开源模型领域表现突出。 • 其他地区:法国(Mistral)、加拿大(Cohere)等也有前沿模型,但中美仍是主导力量。

出口限制与硬件影响:

美国对华限制:

1、时间线:2022年10月首次限制(H100、A100),2023年10月升级(H800、A800受限),2025年1月新增“AI扩散规则”。

2、当前状态:仅H20、L20等低性能芯片可出口中国,未来可能进一步收紧。

3、影响:中国依赖国产芯片(如华为昇腾)或降级版NVIDIA芯片(如H20,算力仅为H100的15%)。

硬件性能对比:

• NVIDIA H100:989 TFLOPs,3.35 TB/s带宽。

• NVIDIA H20:148 TFLOPs,4 TB/s带宽(专为中国市场设计)。

• AMD MI300X:1307 TFLOPs,5.3 TB/s带宽(未受限制)。

中国AI公司概览:

1、大科技公司:

• 阿里巴巴:通义千问(Qwen)系列,Qwen3

• 百度:文心一言(Ernie 4.0 Turbo)

• 腾讯:混元大模型(HunyuanLarge)

• 字节跳动:豆包(Doubao1.6 Pro)

• 华为:盘古5.0(Pangu 5.0 Large)

初创公司:

• DeepSeek:R1、V3,开源模型表现优异。

• Moonshot:Kimi K2,专注长上下文窗口。

• MiniMax:Text-01,多模态能力突出。(2025年10月末发布M2,据说性能突出,价格低廉)

• 其他:智谱AI(ChatGLM)、百川智能(Baichuan)等。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。