服务器怎么选?PCIe GPU服务器选购指南

在AI技术快速发展的今天,GPU服务器已成为支撑人工智能应用的核心基础设施。除了广为人知的大型AI工厂解决方案,市场上还存在着多种适应不同场景的PCIe GPU服务器配置。本文以超微系统为例,为您详细解析2025年PCIe GPU服务器的选购要点。

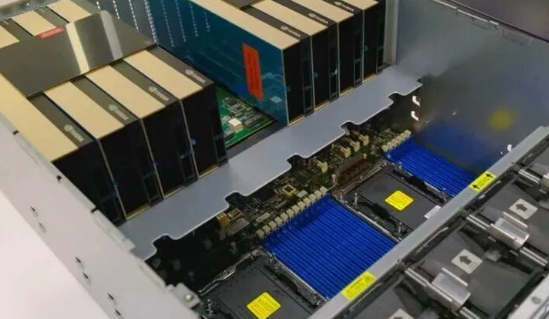

八卡PCIe GPU系统:性价比与灵活性的平衡

八卡PCIe GPU系统在架构上与基于SXM的系统形成互补,具有几个显著优势。这类系统的单卡功耗通常在300W至600W之间,相比SXM方案具有更低的能耗表现。在网络配置上,PCIe系统一般采用每GPU配备两张400GbE网卡的比例,而SXM系统则接近1:1的配比。

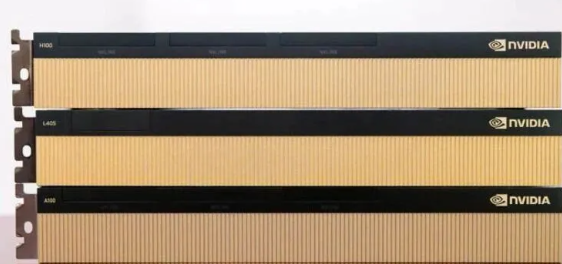

目前主流的PCIe GPU包括NVIDIA H100 NVL/H200 NVL(搭配NVIDIA AI Enterprise软件)、NVIDIA RTX PRO 6000 Blackwell服务器版以及NVIDIA L40S。其中,H200 NVL相比H100 NVL最大的升级在于其更新的HBM内存子系统,特别适合内存密集型工作负载。

NVIDIA RTX PRO 6000 Blackwell GPU的定位更为多元,虽然不具备高带宽内存,但拥有RT核心、编码器和视频输出接口,可同时满足工程设计、虚拟桌面基础设施(VDI)、渲染和AI推理等多种需求。八卡系统通过多实例GPU(MIG)技术最多可分割为32个逻辑GPU实例,提供总计768GB的GPU显存。

超微SYS-522GA-NRT RTX PRO服务器支持8块RTX PRO 6000 Blackwell服务器版GPU,配备双PCIe交换机、双CPU插槽和32个DDR5内存插槽,为网卡和固态硬盘预留了充足的扩展空间。

标准服务器的GPU集成方案

对于大多数企业来说,专用GPU服务器并非唯一选择。将GPU集成到标准服务器中,使其在最适合加速的工作负载阶段发挥作用,正成为越来越流行的解决方案。

与八卡系统类似,这类服务器通常采用NVIDIA H100 NVL、H200 NVL、RTX PRO 6000 Blackwell或L40S等GPU型号。但由于2U服务器机箱的空间限制,一般只能并排安装两张GPU,因此四路NVLink在这种架构中较为少见。

超微SYS-212GB-NR服务器代表了这一设计理念的典型实现,其设计专门优化了GPU的导流风道,确保散热效果。

高密度与边缘计算解决方案

在高密度计算领域,超微SuperBlade系统搭载NVIDIA L4 GPU的方案展现出独特优势。L4 GPU采用薄型设计,散热需求极低,适合高密度整合环境。

边缘服务器则带来了差异化的应用机遇。在零售、智慧城市等场景中,搭载NVIDIA L4 GPU的边缘服务器正驱动着计算机视觉、自主结账系统、库存分析等应用。

超微SYS-E403-14B-FRN2T服务器是边缘计算的典型代表,通过Riser卡配置两块NVIDIA L4 GPU,满足边缘场景严格的功耗与空间要求。

工作站级GPU解决方案

在AI时代,工作站的重要性日益凸显。开发者不仅需要在本地进行AI工具开发,更希望通过配备高性能GPU获得生产力提升。

NVIDIA RTX PRO 6000 Blackwell系列提供三个版本:单槽600W版本、双槽300W主动散热版本和被动散热版本。超微AS-2115HV-TNRT工作站支持四块双宽GPU,突破了传统工作站仅支持三块GPU的限制。

超微还提供AS-531AW-TC和SYS-532AW-C等型号,专门适配不同功耗版本的RTX PRO 6000显卡。

技术发展趋势与选购建议

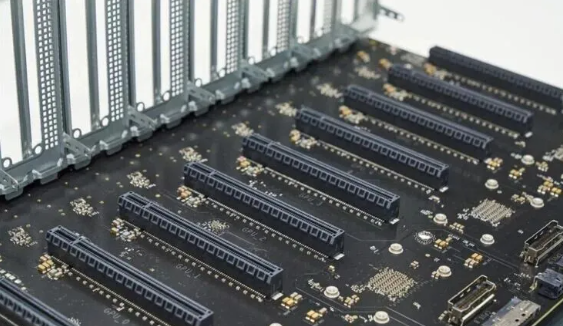

2025年,NVIDIA推出了用于八卡PCIe GPU服务器的MGX PCIe交换板,集成ConnectX-8 SuperNIC,这是平台架构的重要变革。新平台利用ConnectX-8 SuperNIC的内置交换机功能为GPU提供高速网络连接,取代了传统的多个大型交换机方案。

在选择GPU服务器时,需要综合考虑工作负载类型、性能需求、功耗预算和空间限制。对于需要处理混合工作负载的企业,RTX PRO 6000 Blackwell系列提供良好的平衡性;而对于专注于AI推理的场景,H100 NVL/H200 NVL可能更为适合。

结语

随着AI技术深入各行各业,GPU服务器正从专用设备向标准配置转变。从大型AI工厂到边缘计算节点,从高性能工作站到标准企业服务器,PCIe GPU技术正在以多种形态满足不同场景的需求。在选购过程中,关键是根据实际应用需求,选择最适合的GPU型号和服务器配置,在性能、成本和功耗之间找到最佳平衡点。

未来,随着新的GPU、网络技术和架构不断涌现,PCIe GPU服务器的发展前景值得期待。但就目前而言,理解各种应用场景与部署模式,仍是做出明智选择的基础。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。