从跟随到并跑:DeepSeek-V3.2 的逆袭,藏着中国 AI 的突围密码

当Gemini 3.0横空出世,我们在等什么?

11月20日,Google发布了Gemini 3.0 Pro,凭借其碾压级的综合性能,将全球大模型技术推向了新的高度。那一刻,国内AI圈陷入了短暂的沉默。

我们在等什么?

我们在等一个能与之抗衡的国产模型,一个能证明"中国AI不输人"的答案。

10天后,答案来了——DeepSeek-V3.2。

这不仅是一次技术突破,更是一场关于开源精神、技术自主和民族自信的宣言。当OpenAI、Anthropic、Google几乎垄断了全球大模型话语权时,DeepSeek用性能追平Gemini 3.0 Pro、价格仅为1/5、完全开源的成绩,给了所有人一个响亮的回答。

今天,我们就来深度解读这场国产大模型的逆袭之战。

半年磨一剑:DeepSeek的技术长征

如果把大模型竞争比作一场技术军备竞赛,那么DeepSeek走的是一条截然不同的道路。

国外:深厚积淀+商业闭环

OpenAI、Anthropic、Google拥有:

- 数十年的技术积累

- 海量的高质量数据

- 成熟的商业变现模式

- 巨额的研发投入

他们可以慢工出细活,用时间和资源堆砌性能。

国内:开源创新+快速迭代

DeepSeek没有这些优势,只能走开源路线——这意味着:

- 必须通过自主技术创新突围

- 必须保持更快的迭代速度

- 必须用效率对抗资源差距

这是一场不对称的战争,但DeepSeek选择了最硬核的打法。

过去半年的技术长征

让我们回顾DeepSeek在2024年的技术进化路线:

8月下旬 | V3.1发布

- 推出混合推理模型架构

- R1模型正式退出历史舞台

- 奠定了推理优化的基础

9月底 | V3.2实验版发布

- 提出DSA稀疏注意力机制

- 推理和训练成本暴降50%+

- 首次实现性能与成本的平衡

11月底 | MaxV2发布

- 提出自验证数学推理训练法

- 用"左右互搏"突破数学能力极限

- 为Special模型埋下伏笔

12月底 | V3.2正式版+Special发布

- 引入可扩展GRPO训练框架

- 创建大规模合成Agent任务数据集

- 海量强化学习后训练,性能突破极限

每一步都在积累,每一次都在创新。这不是一蹴而就的奇迹,而是技术积累+战略定力的必然结果。

核心突破:V3.2的三大技术创新

DeepSeek-V3.2能够追平Gemini 3.0 Pro,绝非偶然。背后是三大核心技术创新的支撑。

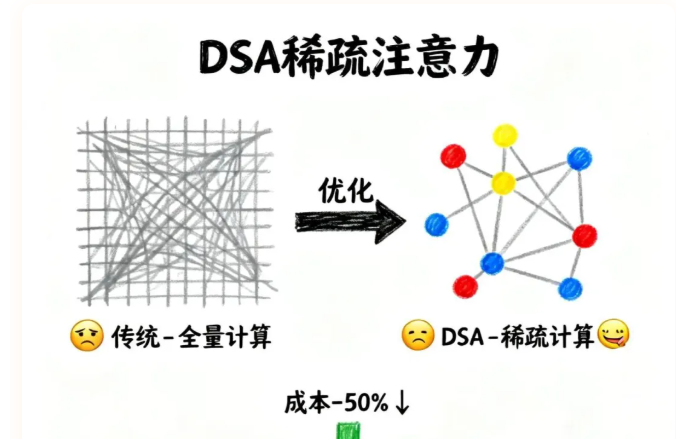

创新一:DSA稀疏注意力机制

问题: 传统注意力机制计算量大,推理成本高昂。

方案: DeepSeek提出DSA(DeepSeek Sparse Attention)机制:

- 动态识别重要token

- 只对关键信息进行注意力计算

- 在保持性能的同时,成本降低50%+

意义: 这不仅是优化,更是架构创新——证明了"更便宜的模型也能有顶级性能"。

创新二:可扩展GRPO训练框架

问题: 强化学习训练容易不稳定,难以长期训练。

方案: DeepSeek开创性提出:

- 无偏KL估计:保证训练目标的准确性

- Off-policy序列掩码:提高样本利用效率

- 可扩展架构:支持更大规模的训练

意义: 解决了GRPO训练的稳定性难题,让"大力出奇迹"成为可能。

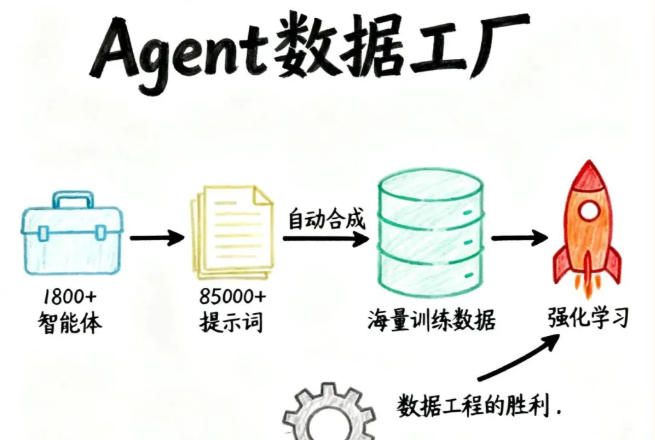

创新三:大规模合成Agent任务数据集

问题: Agent训练需要海量高质量任务数据,但人工标注成本极高。

方案: DeepSeek创建了完整的数据合成流水线:

- 1800+组智能体:覆盖各类任务场景

- 85000+组提示词:自动生成多样化数据

- 海量训练样本:支撑大规模强化学习

意义: 这是数据工程的胜利——证明了合成数据也能训练顶级模型。

双子星:V3.2 vs V3.2 Special

本次发布,DeepSeek带来了两款定位不同的模型,这是一次非常大胆的尝试。

V3.2:生产力王者

定位: 适用于生产环境的通用模型

特点:

- 平衡性能与效率

- 适合日常对话、编程、文档处理

- API稳定,价格友好

性能表现:

- 编程能力:接近GPT-4-turbo水平

- Agent性能:与Gemini 3.0、Claude 3.5差距<5%

- 数学能力:全面领先GPT-4

实测案例:

- ✅ 生成深度学习训练梯度模拟器,效果媲美GPT-4.1 Codex

- ✅ 创建数据可视化游乐场,功能完善度超过Claude 3.5 Sonnet

- ✅ 接入ClaudeCode,无缝替换基座模型

V3.2 Special:极限挑战者

定位: 实验性质的长思考链模型

特点:

- 采用纯推理数据训练

- 放宽思考链长度限制

- 引入自验证数学推理训练法

- 擅长通过长思考解决复杂问题

性能表现:

- 各项评测指标追平Gemini 3.0 Pro

- 数学和编程能力达到奥赛金牌级别

- 但不擅长普通对话(这是设计取舍)

战略意义:

- 这是DeepSeek对"长思考链"技术路线的探索

- 官方限定12月15日API下线,意味着下一代全新模型可能即将到来

- 这种实验性发布,体现了开源社区的技术勇气

实战为王:从编程到Agent的全面胜利

模型性能不能只看评测分数,关键看实际应用。DeepSeek团队进行了大量实战测试。

编程能力:质的飞跃

相比上一代,V3.2在编程方面有巨大提升:

思考链更简洁清晰:

- 不再冗长啰嗦

- 逻辑推理更直接

- 代码意图表达更准确

编程意愿显著提升:

- 一次性编写1000+行代码成为常态

- 不再拆分成多个小片段

- 整体架构更完整

前端审美与代码审查:

- 生成的UI更符合现代设计规范

- 能准确理解复杂项目代码逻辑

- 代码review能力接近人类专家

Agent能力:国产最强基座

测试一:AI PPT Agent

- 基于LangChain构建的生产力级Agent

- 任务拆解准确率显著提升

- 自主提示词编写能力接近Gemini 3.0 Pro

- 外部工具调用准确率>95%

测试二:多Agent智库检索系统

- 包含RAG Agent、Graph RAG Agent、Deep Research Agent

- 用户意图理解准确率提升20%+

- 检索关键词提取准确率提升15%+

- 长文档编写性能媲美Claude 3.5

结论: DeepSeek-V3.2是目前国内最好的Agent基座模型。

思考模式下的工具调用:革命性突破

V3.2首次引入思考模式下的工具调用功能:

传统方式:

- 工具调用是孤立的

- 每次调用都需要重新思考

- 多步任务容易失去上下文

V3.2方式:

- 在单轮任务中保持多步工具调用思考链记忆

- 像人一样可以一边思考一边调用工具

- 多步调用的前后一致性显著提升

这是从"机械执行"到"智能协作"的质变。

性价比:1/5的价格,同等的性能

技术领先很重要,但可及性更重要。

价格对比(每百万token)

- Gemini 3.0 Pro: 约$7

- GPT-4.1: 约$30

- Claude 3.5 Sonnet: 约$15

- DeepSeek-V3.2: 约$1.4

V3.2的价格不到Gemini的1/5,不到GPT-4.1的1/20。

这意味着什么?

对个人开发者:

- 可以用顶级模型做实验

- 可以跑更多测试

- 可以开发更复杂的应用

对创业公司:

- API成本不再是天花板

- 可以支撑更大规模的用户

- 可以尝试更多商业场景

对开源生态:

- 降低了AI应用的准入门槛

- 推动了技术民主化

- 加速了AI在各行业的落地

这不是简单的降价,而是重新定义了"顶级AI"的可及性。

开源的意义:不仅是技术,更是战略

DeepSeek的开源不是作秀,而是深思熟虑的战略选择。

为什么选择开源?

1. 技术验证

- 让全球开发者检验技术方案

- 接受最严苛的实战测试

- 快速迭代优化

2. 生态建设

- 吸引开发者基于V3.2构建应用

- 形成技术社区和应用生态

- 建立事实上的标准

3. 战略对抗

- 在国外闭源模型垄断的格局下

- 开源是中国AI的差异化竞争策略

- 培养自主技术体系

开源了什么?

- ✅ 模型权重(V3.2 + Special)

- ✅ 训练策略(GRPO框架)

- ✅ 技术报告(完整公开)

- ✅ API接口(价格友好)

DeepSeek开源了训练全球顶尖模型的核心策略——这是真正的技术自信。

差距与展望:我们还需要什么?

尽管V3.2取得了巨大成功,但客观地说,与第一梯队仍有差距。

剩余10%的差距在哪?

1. 物理世界理解

- 对现实场景的常识推理

- 多模态融合的深度理解

2. 复杂项目代码逻辑

- 超大型代码库的全局理解

- 跨文件的依赖关系推理

3. 长期对话一致性

- 超长上下文的记忆保持

- 多轮对话的人格稳定性

但这10%差距正在快速缩小

原因一:技术积累在加速

- 每次迭代都在缩小差距

- 创新速度快于国外厂商

原因二:开源生态在助力

- 全球开发者贡献经验

- 实战反馈加速优化

原因三:Special模型的启示

- 长思考链技术已经验证

- 下一代模型可能实现质变

12月15日之后会发生什么?

Special模型的API将在12月15日下线,这传递出一个信号:下一代全新的DeepSeek模型可能即将到来。

如果新模型能将Special的长思考能力与V3.2的通用性结合,那将是真正的全面追平甚至超越Gemini 3.0 Pro。

结语:这是开始,不是终点

这不仅是一次技术突破,更是一种精神:

- 在资源劣势下不放弃

- 在技术封锁中自主创新

- 在商业垄断前坚持开源

DeepSeek用半年时间,从V3.1到V3.2,从实验版到正式版,从跟随到并跑,走完了一条完整的技术长征。这条路上没有捷径,只有持续创新+战略定力。

但这只是开始。

10%的差距正在缩小,Special模型展示了新的可能,下一代模型呼之欲出。中美AI的技术军备竞赛远未结束,但至少,我们已经站在了同一起跑线上。

更重要的是,V3.2的开源让全球数百万开发者都能用上顶级模型,这种技术民主化的力量,最终会改变整个AI产业的格局。

2025年,我们继续见证历史。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。