数据策展是什么?从基础清洗到元学习,大模型数据优化全流程

第一部分:数据策展的基础

第一章:大模型时代以数据为中心的迫切需求

1.1. 范式转移:从以模型为中心到以数据为中心的人工智能在人工智能领域,尤其是在基础模型(Foundation Models)的时代,一个根本性的转变正在发生:研究和开发的重心正从以模型为中心(Model-Centric)的架构创新,决定性地转向以数据为中心(Data-Centric)的策略1。长久以来,学术界和工业界将大量精力投入到设计更复杂的神经网络架构中。然而,随着模型规模的急剧膨胀,一个共识日益清晰:基础模型的质量、能力和安全性,在根本上取决于其训练数据的质量3。这一转变标志着对模型性能驱动因素的重新认识,即数据不再是静态的输入,而是提升模型能力、效率和可靠性的核心杠杆 4。

“在所有可用数据上天真地训练模型可能并非最优(或可行)”这一观点已成为业界的普遍认知 4。原始的、未经处理的网络爬取数据充满了噪声、冗余、偏见和潜在的有害内容。直接使用这些数据不仅会浪费巨大的计算资源,还可能导致模型产生不可靠、带有偏见甚至危险的输出。因此,数据策展(Data Curation)——一个涵盖数据收集、清洗、筛选、增强和组织的系统性过程——已经从一个辅助性的预处理步骤,演变为构建强大、高效和安全基础模型的战略核心。这种范式转移强调,精心策展的数据集能够比更大但质量低劣的数据集产生更优越的模型,从而将数据质量置于数量之上 2。

1.2. 数据策展的多重目标数据策展的目标是多维度的,远不止是简单地提升模型的预测准确率。它旨在全面优化模型的生命周期,从训练效率到部署后的可靠性。

1.3. 策展实践的演进格局数据策展的方法论本身也在经历一场深刻的演变。最初,策展工作主要依赖于人工定义的、基于启发式规则的流程,这种方法虽然直观,但扩展性差且容易出错 17。随着领域的发展,我们见证了向更自动化、更智能的策展工作流的转变。

一个显著的趋势是,从业者正在从“启发式优先、自下而上”的分析方法,转向由大型语言模型(LLM)支持的“洞察优先、自上而下”的工作流 17。这意味着不再是手动从细粒度的数据中构建洞察,而是利用LLM首先生成高层次的摘要和分类,然后根据需要深入细节。

- 为了应对日益复杂的数据环境,数据策展领域还出现了多层次的数据集等级体系。传统的由领域专家创建的“黄金数据集”(golden datasets)现在得到了补充。一方面是利用LLM生成的“白银数据集”(silver datasets),用于快速扩充数据;另一方面是经过更多专家严格验证的“超金数据集”(super golden datasets),用于对模型进行更可靠的基准测试和评估 17。这一演变反映了数据策展正从一项孤立的技术任务,转变为一个涉及多方利益相关者(如安全团队、领域专家、工程经理)的协作过程,共同定义和实现“数据质量” 17。

- 这种从手动到自动、从孤立到协作的演进,不仅提升了策展的效率和规模,也深化了我们对数据价值的理解。数据策展不再仅仅是“清洗垃圾”,而是成为一门精确的科学和艺术,旨在为基础模型精心雕琢出最优的学习环境。这种转变的背后,是深刻的经济和战略考量。训练大型模型的巨大成本 4 与有效数据策展所能带来的计算资源节省 3 之间形成了鲜明的对比。因此,在数据策展上的投入(包括计算资源和人力成本)可以被视为一种高回报的投资,其收益体现为训练成本的降低和模型质量的提升。这解释了为何“有效的数据选择实践知识已经集中在少数几个组织中” 5,因为卓越的策展技术本身就是一种核心的竞争优势。反之,不当策展所带来的风险(如部署一个有偏见或不安全的模型)则构成了巨大的潜在负债 14,这使得如何策展的决策,从根本上成为一项核心的商业战略。

第二章:单模态策展流水线:为LLM准备文本

2.1. 第一阶段:基础清洗与去重

在为大型语言模型准备训练数据时,第一道防线是建立一个稳健的基础清洗和去重流水线。这一阶段通常由一系列基于启发式规则的自动化脚本构成,旨在从海量的原始数据中移除最明显的低质量内容。

2.2. 第二阶段:基于质量的高级选择

在完成基础清洗和去重之后,策展流水线进入了更高级的阶段,目标是主动识别和筛选出对模型训练最有价值的数据。

2.3. 第三阶段:优化数据构成(混合问题)

仅仅筛选出高质量的单个数据点是不够的,如何以最佳比例混合来自不同来源或领域(Domain)的数据,是决定最终模型能力的关键一步,这被称为数据混合(Data Mixing)问题 39。

数据策展的演进路径清晰地展示了该领域从粗糙到精细、从局部到全局的成熟过程。最初,像C4这样的方法依赖于简单的、有时甚至是脆弱的启发式规则,这是一种“减法”逻辑——移除坏的部分 21。随后,RefinedWeb和The Pile等方法引入了更稳健的原则,关注于数据的结构完整性(去重)或来源质量(组合),这是一种更有原则的“加减法” 23。然而,静态规则的局限性催生了对学习数据质量的需求,如使用分类器或困惑度评分 31。在这里,“质量”不再由人工规则定义,而是从数据中学习到的一个分数。这一演进的最终阶段是优化整个数据集的构成,即数据混合 39,承认了数据的价值不仅在于个体,更在于其组合。整个发展轨迹表明,数据策展正在从基于局部启发式的决策,迈向基于全局目标的优化。

第二部分:自动化与多模态策展的前沿

第三章:学会选择:元学习范式

3.1. 超越静态规则:学习数据价值

随着数据策展任务变得日益复杂,传统的手工启发式规则的局限性也愈发明显。这些规则不仅开发成本高,而且扩展性差,难以适应多样的、不断变化的数据分布。为了克服这些挑战,研究领域开始转向一种更高级的范式:元学习(Meta-Learning)3。元学习的核心思想不再是直接学习如何完成某个任务(例如,语言建模),而是“学习如何学习”(learning to learn)。在数据策展的背景下,这意味着让模型自己去“学习哪些数据对训练真正有价值” 3。通过定义一个更高层次的优化目标(例如,最大化训练效率或最终模型性能),元学习方法能够自动发现并量化数据点的价值,从而实现更精细、更有效的策展。

3.2. 深度剖析:DataRater

DataRater是元学习策展思想的一个杰出实例,它旨在自动化地评估每个数据点对于训练基础模型的价值 3。

3.3. 其他基于学习的框架

除了DataRater,其他一些工作也探索了通过学习来优化数据选择的思路。

这些基于学习的框架代表了数据策展领域的一个重要演进方向。它们不再依赖于人工预设的、关于“什么”是坏数据的静态描述性规则(例如,“移除包含‘lorem ipsum’的行” 21)。相反,它们通过定义一个关于“为什么”数据是坏的的功能性目标(例如,“因为它损害了训练效率” 3)来驱动策展过程。在这个过程中,具体的筛选“规则”是作为优化过程的涌现属性(emergent property)被学习到的,而不是预先设定的约束。这种机制使得策展系统更加强大和自适应,能够发现人类策展员可能从未想到过的、微妙的低质量数据模式。这预示着,数据策展的未来可能更多地在于设计更优越的元目标(例如,除了效率,还可以是公平性、鲁棒性或事实性),并让系统自动学习实现这些目标的最佳数据选择策略。

第四章:策展多模态网络:对齐视觉与语言

4.1. 多模态数据的独特挑战

随着大型语言模型(LLM)向多模态大型语言模型(MLLM)的演进,数据策展面临着新的、更为复杂的挑战 47。一个典型的MLLM架构包含三个核心模块:用于处理不同感官输入的预训练模态编码器(如图像编码器)、作为认知核心的预训练LLM,以及连接两者的模态接口 47。这种结构决定了多模态数据策展的双重任务:不仅要确保每个单一模态数据的质量(例如,图像清晰无遮挡,文本通顺无误),更要保证不同模态之间的

语义对齐(semantic alignment)10。一张高质量的图片配上一段不相关的文字,对于训练MLLM而言是毫无价值甚至有害的。

4.2. 基础技术:基于CLIP的过滤

在多模态数据策展领域,基于CLIP模型的过滤是一种 foundational 的技术,其最著名的应用是LAION-5B数据集的构建。

4.3. 先进的多模态策展技术

为了克服简单CLIP过滤的局限性,研究界正在探索一系列更先进的多模态策展技术。

这些先进技术的出现,揭示了数据策展领域一个深刻的趋势:策展与模型优化之间的界限正在变得模糊。特别是在多模态领域,像ACID这样的方法表明,智能的数据选择本身就是一种强大的模型训练技术。传统上,知识蒸馏通过在目标函数层面的干预(即增加一个模仿损失)来传递知识 60。而ACID则在数据层面实现了类似的目标,它通过精心挑选训练数据来引导模型的学习轨迹,从而实现“隐式蒸馏” 60。更重要的是,研究发现ACID和传统的显式知识蒸馏是互补的,这意味着它们传递了不同类型的信息,可以结合使用以获得更好的效果 60。这强烈地表明,数据策展已不再仅仅是关于“数据清洗”的辅助工作,它正在演变为一种能够实现定向知识迁移和高效模型优化的核心机制。

第三部分:综合与未来展望

第五章:比较分析与综合

5.1. 宏观综合:一个比较框架

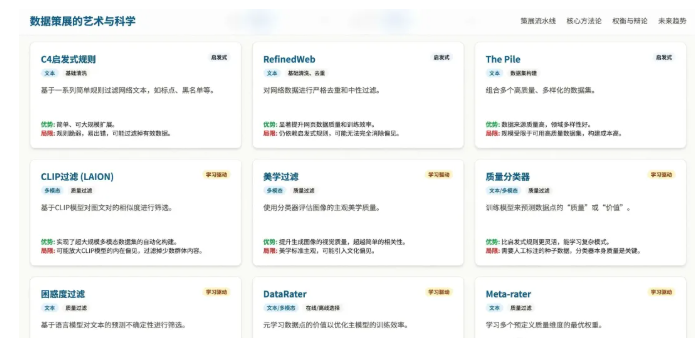

为了系统地梳理和比较前文讨论的各种数据策展方法,下表提供了一个综合性的框架。该表格旨在将这个复杂且快速发展的领域提炼成一个结构化的、可供比较的格式,从而为研究人员和实践者提供一个快速定位和理解不同技术路径的工具。它将各种方法论按照其核心思想、适用模态、策展阶段、实现机制、主要贡献和局限性进行了分类,将分散的信息转化为可操作的知识。

| 方法/论文 | 核心思想 | 模态 | 策展阶段 | 机制 | 主要贡献与优势 | 已知局限性与成本 |

|---|---|---|---|---|---|---|

| C4启发式规则 | 对网络爬取数据进行基于规则的过滤 19 | 文本 | 基础清洗 | 启发式规则(如标点、词表黑名单、行长) | 简单、可大规模扩展 | 规则脆弱、易出错,可能过滤掉有效数据,透明度低 22 |

| RefinedWeb | 对网络爬取数据进行严格的去重和中性过滤 23 | 文本 | 基础清洗、去重 | 启发式规则、URL过滤、严格的模糊/精确去重 | 提升了网页数据的质量和训练效率,去重彻底 13 | 仍然依赖启发式规则,可能无法完全消除偏见 |

| The Pile | 组合多个高质量、多样化的数据集 24 | 文本 | 数据集构建 | 来源选择、组合、定制化预处理 | 数据来源质量高、领域多样性好 26 | 规模受限于可用高质量数据集,构建成本高 |

| CLIP过滤 (LAION) | 基于CLIP模型对图像-文本对的相似度进行筛选 49 | 多模态 | 质量过滤 | CLIP相似度得分 | 实现了超大规模多模态数据集的自动化构建 49 | 可能放大CLIP模型的内在偏见,过滤掉少数群体内容 51 |

| 美学过滤 | 使用分类器评估图像的主观美学质量 55 | 多模态 | 质量过滤 | 分类器(通常基于CLIP嵌入) | 提升生成图像的视觉质量,超越简单的相关性过滤 56 | 美学标准具有主观性,可能引入文化偏见 |

| 质量分类器 | 训练模型来预测数据点的“质量”或“价值” 31 | 文本/多模态 | 质量过滤 | 机器学习分类器(如fastText, LLM) | 比启发式规则更灵活,能学习更复杂的质量模式 33 | 需要人工标注的种子数据,分类器本身的质量是关键 32 |

| 困惑度过滤 | 基于语言模型对文本的预测不确定性进行筛选 34 | 文本 | 质量过滤 | 语言模型困惑度 | 计算成本低,能有效去除模板化或混乱的文本 | 困惑度与真实质量并非完全相关,可能误删有创意或复杂的文本 35 |

| DataRater | 元学习数据点的价值以优化主模型的训练效率 3 | 文本/多模态 | 在线/离线选择 | 元梯度 | 自动发现未知的低质量数据模式,显著提升计算效率 3 | 元训练过程计算成本高,需要一个代理模型 |

| Meta-rater | 学习多个预定义质量维度的最优权重 9 | 文本 | 质量过滤 | 回归模型 | 提供了可解释的多维度质量评估框架 | 预定义的维度可能不全面,依赖代理模型打分 |

| PDS | 将数据选择建模为最优控制问题 46 | 文本 | 数据选择 | 庞特里亚金最大值原理 | 提供了坚实的理论基础,将选择与训练动态联系起来 | 计算上非常密集,实际应用中需要大量简化 |

| ACID | 通过主动数据选择实现隐式知识蒸馏 60 | 多模态 | 在线批量选择 | 基于参考模型的损失进行采样 | 实现了无需蒸馏损失的高效模型压缩,与显式KD互补 61 | 依赖一个高质量的参考模型,增加了推理开销 |

| JEST | 联合选择整个数据批次以最大化联合可学习性 62 | 多模态 | 在线批量选择 | 联合可学习性度量 | 显著加速对比学习,证明了批次内样本的协同效应 | 增加了批次选择的计算复杂度,需要从更大的超批次中采样 |

| EcoDatum | 集成多种策展操作器的弱监督框架 48 | 多模态 | 质量过滤 | 集成学习/弱监督 | 整合了多种质量信号,比单一指标更鲁棒 | 框架设计复杂,需要协调多个不同的数据操作器 |

5.2. 贯穿性主题与辩论

从上述比较框架中,我们可以提炼出数据策展领域几个核心的、贯穿性的主题和持续的辩论。

第六章:数据策展的未来:新兴趋势与开放挑战

6.1. 演进中的数据生态系统

大型语言模型的出现不仅是被策展的对象,它们本身也正在成为强大的策展工具,深刻地改变着数据策展的实践。

6.2. 未来研究方向与开放挑战

数据策展作为一个充满活力的领域,未来仍有许多值得探索的方向和亟待解决的挑战。

结语

综上所述,数据策展已经从一项被视为“数据清理”的辅助性、甚至有些繁琐的工作,发展成为一门核心的科学与工程学科。它深刻地影响着人工智能模型的性能、效率、安全性乃至经济可行性。在基础模型的浪潮中,对数据价值的理解和利用能力,正成为区分领先者与追随者的关键。未来的技术突破,将同样甚至更多地来自于数据策展的创新,而非仅仅是模型架构的革新。精心策展的数据,是通往更强大、更可靠、更负责任的人工智能的必由之路。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。