谷歌搜索不收录是什么原因?怎么解决?

你是否投入大量精力优化网站,却始终无法在谷歌搜索结果中找到它的身影?明明内容和外链都下了功夫,收录却屡屡碰壁?

其实,谷歌收录的核心逻辑从未改变 —— 让爬虫 “找得到、读得懂”,让内容 “够相关、有价值”。

但随着算法持续迭代,对用户体验和内容质量的评判标准不断升级,除了经典问题,更涌现出不少易被忽视的 “隐形坑”。

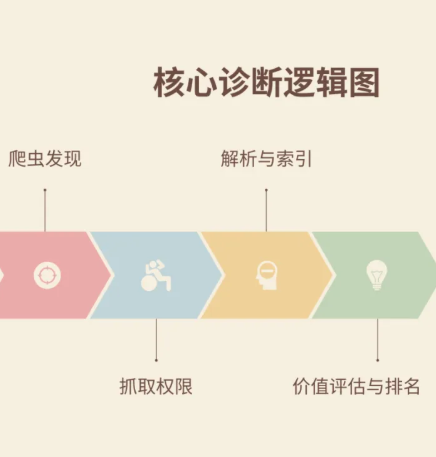

谷歌收录从来不是单一环节的问题,而是一套环环相扣的系统工程,遵循清晰的逻辑链:爬虫发现 → 获得抓取权限 → 成功解析页面 → 内容价值评估 → 最终进入索引。

这其中任何一个环节断裂,都会导致收录失败。

本文将成为您的终极诊断手册。我们将不再满足于表面的解决方案,而是潜入技术底层和算法逻辑,为您提供一套完整、可执行且极具深度的修复方案。

第一阶段:核心抓取与索引权限问题

问题一、网站太新,爬虫尚未发现

谷歌爬虫(Googlebot)发现新网站主要有两种途径:其一,通过互联网上已有的链接,像顺着蜘蛛网一样爬行到您的网站;其二,通过您主动提交的指引(如Sitemap)。一个全新的、没有任何外部链接指向的网站,对谷歌来说就是一个“信息孤岛”。纯粹被动等待,收录周期会非常漫长且不确定。这不仅仅是时间问题,更是“信号”强弱的问题。

解决方案

- 强信号主动引导:Google Search Console:这不仅是“提交”,更是“宣告”。验证并提交XML站点地图后,立即使用 “URL检查工具” 对您的首页、核心产品/服务页、关键分类页进行“请求编入索引”。这个操作会直接触发谷歌爬虫对该URL的即时抓取和渲染,是最高优先级的引导信号。索引API:对于大型或新闻类网站,可以考虑使用Google的Indexing API,这能实现近乎实时的收录通知,是最高效但技术门槛也较高的方式。

- 构建早期引导链接:社交信号:在LinkedIn、Twitter(X)、Facebook、Reddit等相关行业的社区和群组中,分享您网站的链接。即使这些链接大多是nofollow,但它们作为强大的“发现信号”,能有效引导爬虫。资源平台外链:在GitHub上创建一个与您业务相关的开源代码片段或工具;在Medium或LinkedIn Articles上发布文章摘要并链接回您网站的原文;在相关行业的知名论坛(如Quora)的回答中,有价值地植入您的链接。这些平台本身权重高,是极佳的爬虫入口。

- 服务器可访问性保障:

使用GSC的“设置”->“抓取统计信息”查看谷歌爬虫的访问频率和最后下载页面的时间。如果长期为空或频率极低,需要排查:

- 服务器响应时间:确保在全球范围内访问速度均低于800毫秒。

- IP信誉:确保您的服务器IP地址没有被滥用历史,未被列入任何垃圾邮件黑名单。

- 地区屏蔽:检查您的服务器防火墙或.htaccess文件,是否误屏蔽了谷歌爬虫IP段(如来自美国的访问)。

问题二、robots.txt 文件配置错误

robots.txt 是网站根目录下的一个协议文件,它是指示爬虫行为的第一个关口。一个错误的 Disallow: / 指令,就如同在门口挂上了“禁止入内”的牌子,会直接导致全站被屏蔽。更常见的是错误地屏蔽了CSS、JS等重要资源目录,导致谷歌无法正确渲染页面,从而认为页面内容贫乏。

解决方案

精准诊断与验证:

访问 https://您的域名.com/robots.txt,仔细检查每一行指令。

必须使用GSC的“robots.txt测试工具”。输入您最重要的几个URL,确保状态显示为“允许”。同时,也要测试您不希望被抓取的URL(如后台登录页),确保状态为“已屏蔽”。

高级与精细化配置:

一个专业且安全的 robots.txt 文件示例如下:

| # 允许所有主流爬虫User-agent: *# 禁止抓取无价值、私密或资源密集型页面Disallow: /wp-admin/Disallow: /search/Disallow: /login/Disallow: /includes/# 特别允许爬虫抓取对渲染必要的AJAX功能Allow: /wp-admin/admin-ajax.php# 针对特定爬虫的精细控制(示例)User-agent: Googlebot-ImageAllow: /assets/images/ # 允许图片爬虫抓取图片库Disallow: /assets/logos/ # 但可以不抓取Logo库# 明确指示站点地图位置,提供完整路径图Sitemap: https://您的域名.com/sitemap_index.xml |

问题三、noindex 标签阻止索引

这是最常见的技术性错误。

noindex 是一个元指令,它直接告诉谷歌:“请不要将这个页面放入索引库”。它的优先级极高,甚至会覆盖其他积极的SEO信号。问题常常不是故意设置,而是意外产生的:例如,网站开发环境的上线前设置未移除;WordPress等CMS的全局设置错误;或者SEO插件在特定页面类型(如标签页、作者页)上的默认配置就是noindex。

解决方案

- 系统性批量审计:使用 Screaming Frog SEO Spider 这类爬虫工具,抓取整个网站。在爬取完成后,使用过滤器直接筛选出所有包含 noindex 指令的页面。关键步骤:同时检查这些页面的 canonical 标签。确保它们是“自指向”的(即指向自身URL),而不是错误地指向了其他页面,这同样会导致索引问题。

- 根源排查与修复:CMS全局设置:对于WordPress,检查“设置”->“阅读”中的“搜索引擎可见性”。对于其他CMS,找到类似的全局索引开关。SEO插件设置:深入检查Yoast SEO、Rank Math等插件的设置。确保“帖子类型”、“分类法”等选项中,您希望被收录的内容类型(如文章、页面、产品)的默认索引状态是“yes”。模板级检查:检查网站的页眉(header.php)模板,确保没有全局性地插入noindex标签。缓存清理:任何修改后,务必清除服务器、CDN及插件的缓存,确保爬虫看到的是最新版本。

第二阶段:技术架构与内容可访问性问题

问题四:网站性能与架构——“爬取预算”的隐形杀手

深度原理解析:谷歌为每个网站分配了有限的“爬取预算”——即在一定时间内,谷歌爬虫愿意并能够抓取的页面数量。一个加载缓慢、充满死链和复杂重定向的网站,会大量消耗爬虫预算。导致的结果是,爬虫在抓取完一些无价值的页面或耗尽时间之前,根本无法触及您那些重要的深层内容页面。

解决方案:

性能优化:

核心网页指标:使用Google的PageSpeed Insights和GSC的“核心网页指标”报告。您需要关注的不仅是分数,更是LCP、FID、CLS这三个具体指标。优化大图加载、减少第三方脚本、稳定页面布局等操作,都是针对这些指标的。

技术栈优化:启用GZIP压缩、优化CSS/JS(合并、最小化)、使用下一代图片格式、配置浏览器缓存。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。