什么是 LLMs.txt?AI 爬虫管控与内容训练权限指南

大多数网站所有者并不知道大型语言模型(LLM)已经收集了多少内容。ChatGPT、Claude和Gemini除非你另有说明,否则会从公开页面中提取资源。这正是LLMs.txt SEO的用武之地。

LLMs.txt给你一个直接的方式告诉AI爬虫如何使用你的内容。它不会改变排名,但增加了对模型训练的控制层,这是以前没有的。

这很重要,因为如今AI生成的答案在搜索结果中占据了更多篇幅。除非你明确选择退出,否则你的内容可能会助长这些答案。LLMs.txt明确规定了哪些允许、哪些不允许,让你在这个快速发展且缺乏网站所有者参与的领域中拥有优势。

无论你允许还是限制访问,LLMs.txt都为管理你内容在AI驱动体验中的呈现方式设定了基准。

什么是 LLMs.txt?

LLMs.txt是一个简单的文本文件,你放在域名根节点,用来提示AI爬虫如何与你的内容交互。如果robots.txt指南是搜索引擎爬虫,LLMs.txt指南则是大型语言模型爬虫。其目标是确定你的公共内容是否会成为GPT-4、Claude或Gemini等模型使用的训练数据集的一部分。

文件控制的内容如下:

- 每个AI爬虫的访问权限

- 是否可以使用特定内容进行培训

- 您的网站如何参与AI生成的答案

- 对数据共享规则的透明文档

这个协议的存在是因为人工智能公司大规模收集训练数据。除非你明确选择退出,否则你的内容可能已经出现在数据集中。LLMs.txt增加了之前不存在的同意层,让你直接表达界限。

OpenAI、Anthropic和Google因应对对所有权和未经授权数据使用的日益担忧,推出了对LLMs.txt的支持。虽然尚未普及,但随着越来越多的组织要求对人工智能访问的明确性,这一趋势正在迅速增长。

LLMs.txt没有替换robots.txt因为两个文件承担不同的职责。Robots.txt负责搜索引擎的爬取,LLMs.txt负责AI模型的训练权限。它们共同帮助您保护内容,制定可见性规则,并为AI驱动搜索持续扩展的未来做好准备。

为什么LLMs.txt现在是优先事项?

模型开发者收集大量数据集,其中大部分来自公开内容。当OpenAI于2023年推出GPTBot时,也为网站提供了退出的途径。谷歌随后推出了谷歌扩展,允许出版商限制其内容的人工智能训练。Anthropic等公司很快实施了类似的机制。

这种转变有一个重要原因:除非你明确说明,否则你的内容可能已经是AI生态系统的一部分。

LLMs.txt正在成为标准,因为网站所有者希望获得清晰。直到最近,还没有正式的方式表达你的内容是否可以在模型训练流程中被重新利用。现在你可以用一个文件来定义这个选择。

这还有另一个角度。生成式搜索工具越来越依赖训练数据来生成答案。如果你屏蔽了AI爬虫,你的内容可能不会出现在这些输出中。如果你允许访问,你的内容将有资格在对话式回复中被引用,这与品牌对大型语言模型SEO策略的策略密切相关。

这两种方法都不适合所有人。有些公司希望内容控制更严格。还有人希望在AI驱动领域获得更强的可见性。LLMs.txt帮助你设置位置,而不是默认进入一个位置。

随着AI生成搜索日益普及,LLMS.txt的重要性也在增长。你可以随着时间调整指令,但有了文件,你就能掌控当前内容的使用方式。

LLMs.txt工作原理

LLMs.txt 是一个位于你域名根节点的纯文本文件。支持该协议的 AI 爬虫会读取它,了解他们可以使用你内容的哪些部分。你设定规则,上传一次文件,并在策略变化时更新。

它所在的地方

LLMs.txt必须放置在:

yoursite.com/llms.txt

这与robots.txt的结构相呼应,也让爬行者保持了可预测性。每个支持的AI机器人都会检查这个具体位置以查找你的规则。必须在根目录里才能正常工作,子文件夹不会被注册。

该文件是有意公开的。任何人都可以通过直接导航到网址查看。这种透明度让AI公司、研究人员和合规团队能够看到你所表达的偏好。

你能控制的

在LLMs.txt里,你指定了单个AI爬虫的允许或不允许指令。示例:

User-agent: GPTBotDisallow: /User-agent: Google-ExtendedAllow: /你可以授予通用权限或屏蔽所有内容。该文件为你提供细致控制,控制你的公开内容如何流入AI训练数据集。

目前尊重它的大型语言模型

几个主要的AI爬虫已经自动检查LLMs.txt:

- GPTBot (OpenAI)——支持选择加入和退出的训练规则

- Google-Extended——用于谷歌生成式人工智能系统

- ClaudeBot (Anthropic) ——遵守站点层级指令

- CCBot (Common Crawl) ——贡献于许多模型使用的数据集

- PerplexityBot — 2024 年早期采用者

行业内支持各异,但方向很明确:越来越多的爬虫正围绕LLMs.txt作为培训同意的标准化方法。

LLMs.txt与Robots.txt:有什么区别?

Robots.txt和LLMs.txt有互补但不同的目的。

Robots.txt控制传统搜索引擎爬虫如何访问和索引你的内容。其重点是SEO:可发现性、爬取预算以及页面在搜索结果中的呈现方式。

相比之下,LLMs.txt则规范了人工智能模型如何利用你的内容进行训练。这些指令告诉模型爬虫他们是否能读取、存储和学习你的页面。

它们的不同之处如下:

- 不同的爬虫:Googlebot和Bingbot也效仿robots.txt;GPTBot、ClaudeBot 和 Google 扩展阅读LLMs.txt。

- 不同的结果:Robots.txt影响排名和索引。LLMs.txt会影响你的内容在生成式人工智能系统中的呈现方式。

- 不同的风险与回报:Robots.txt会影响搜索可见度。LLMs.txt影响品牌在AI生成回答中的曝光度——以及你对专有内容的控制。

随着搜索向混合AI和传统结果的转变,这两个文件正成为基础。随着AI驱动的发现扩展,你很可能需要每个人协同工作。

你应该用LLMs.txt进行SEO吗?

LLMs.txt现在并没有直接排名的好处。搜索引擎不会为SEO目的解读它。不过,这会影响你的内容如何参与生成结果,这很重要。

允许AI爬虫为模型提供了更多上下文,提高了你的内容出现在综合答案中的概率。屏蔽爬虫可以保护专有或敏感内容,但会让你远离这些基于AI的接触点。

你的方法取决于你的目标。专注于触达的品牌通常允许访问。专注于独占性或知识产权保护的品牌通常会限制这种限制。

LLMs.txt也非常适合深思熟虑的大型语言模型优化工作。内容结构化,强调清晰、强烈信号和上下文相关性,有助于模型更准确地解读你的材料。LLMs.txt只是决定了他们是否可以从中学习。

“LLMs.txt不会改变今天的排名,但它为你的内容与AI系统之间的互动设定了早期规则。可以把它想象成robots.txt早期:现在小,后面打基础。“NP Digital高级SEO经理Anna Holmquist解释道。

谁真的需要LLMs.txt?

有些网站比其他网站更适合早期采用LLMs.txt。

- 内容密集型网站出版商、教育机构和文档库通常希望对内容被AI系统复用的方式进行规范管理。

- 拥有专有内容的品牌若您的收入依赖于高级报告、付费内容或专业数据集,LLMs.txt可提供必要的保护层。

- 规划AI搜索策略的SEO从业者随着生成式结果日益普及,品牌方亟需掌控内容向答案引擎的输送机制。LLMs.txt在保障可见性的同时,能有效划定数据边界。

- 受合规要求约束的行业医疗、金融及法律机构通常需遵循严格的数据处理规范。阻断AI爬虫已成为其治理策略的重要环节。

LLMs.txt不会让你陷入长期决定。你可以随着AI搜索的发展来更新它。

如何设置LLMs.txt文件

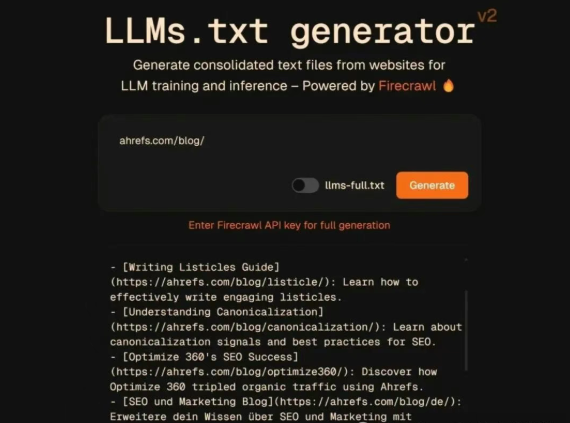

设置LLMs.txt文件很简单。流程如下。如果你需要帮助,有工具和生成器可以帮你。

1. 创建文件

打开一个纯文本编辑器,创建一个名为llms.txt的新文件。

请在顶部添加一条评论以求清晰:

# LLMS.txt — AI crawler access rules2. 添加机器人指令

定义哪些爬虫可以读取并训练你的内容。例如:

User-agent: GPTBotDisallow: /User-agent: Google-ExtendedAllow: /你可以全局开启或关闭访问权限:

User-agent: *Disallow: /or:User-agent: *Allow: /3. 上传到根目录

请将文件放置在:

yoursite.com/llms.txt

这个位置是爬虫检测到它所必需的。子文件夹无法使用。

4. 监控AI爬虫活动

查看服务器日志以确认以下活动:

- GPTBot

- ClaudeBot

- Google-Extended

- PerplexityBot

- CCBot

这有助于你核实指令是否按预期运作。

常见问题解答

什么是 LLMs.txt?

这是一个文件,告诉AI爬虫是否能训练你的内容。它和robots.txt类似,但专门为大型语言模型设计。

ChatGPT 会用LLMs.txt吗?

是的。OpenAI的GPTBot会检查LLMs.txt并遵循你指定的规则。

我该如何创建LLMs.txt文件?

创建一个纯文本文件,添加爬虫规则,并上传到你网站的根目录。用上面的例子来设定你的指令。

结论

LLMs.txt为出版商定义其内容如何与AI训练系统互动提供了途径。随着AI生成搜索的扩展,拥有明确的规则有助于保护你的作品,同时让你掌控品牌在模型生成答案中的形象。

这个文件自然地与更强有力的大型语言模型SEO策略搭配,帮助你塑造AI驱动环境中内容的发现方式。如果你已经在提升内容结构以提升模型理解,LLMs.txt与正在进行的大型语言模型优化工作并列。

本文内容仅供参考,不构成任何专业建议。使用本文提供的信息时,请自行判断并承担相应风险。